Simon Collin, Université du Québec à Montréal

Alexandre Lepage, Université de Montréal

Léo Nebel, Sorbonne Université et EvidenceB

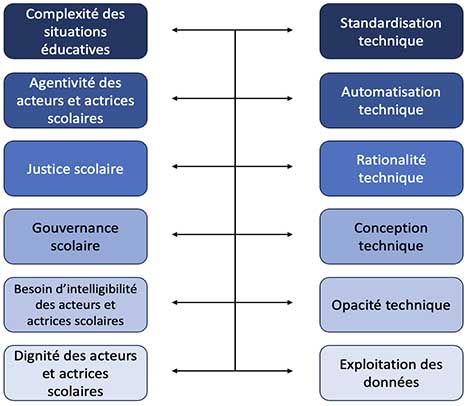

Bien qu’ils aient été étudiés depuis les années 2000, les enjeux que suscitent les systèmes d’intelligence artificielle (IA) lorsqu’ils sont utilisés éducation (SIA-ED) font actuellement l’objet d’une attention croissante dans la littérature scientifique. Il est toutefois difficile d’en avoir une vue synthétique car ils sont abordés par les chercheurs et chercheuses au travers de terrains éducatifs, de techniques computationnelles et d’angles d’analyse hétérogènes. Aussi, l’objectif de cet article est de mener une revue systématique de la littérature sur les enjeux éthiques et critiques des SIA-ED afin d’en avoir un meilleur portrait. Une analyse de 58 documents scientifiques nous a amenés à identifier 70 enjeux éthiques et critiques des SIA-ED, que nous avons organisés sous 6 tensions : complexité des situations éducatives vs standardisation technique ; agentivité des acteurs et actrices scolaires vs automatisation technique ; justice scolaire vs rationalité technique ; gouvernance scolaire vs conception technique ; besoin d’intelligibilité des acteurs et actrices scolaires vs opacité technique ; dignité des acteurs et actrices scolaires vs exploitation des données.

Mots-clés : systèmes d’intelligence artificielle ; éducation ; enjeux éthiques et critiques ; revue systématique de la littérature

Although studied since the 2000s, the issues raised by artificial intelligence (AI) systems in education are currently receiving increasing attention in the scientific literature. However, obtaining a comprehensive overview is challenging due to researchers approaching them through diverse educational contexts, computational techniques, and heterogeneous analytical perspectives. Therefore, the objective of this study was to conduct a systematic review of the literature on the ethical and critical issues of AI systems in education to gain a better picture of them. An analysis of 58 scientific documents led us to identify 70 ethical and critical issues of AI systems in education, which were organized under 6 tensions: complexity of educational situations vs. technical standardization; agentivity of educational actors vs. technical automation; educational justice vs. technical rationality; school governance vs. technical design; need for intelligibility of educational actors vs. technical opacity; and dignity of educational actors vs. exploitation of data.

Keywords: artificial intelligence systems; education; ethical and critical issues; systematic review of the literature

La Déclaration de Montréal pour un développement responsable de l’intelligence artificielle (2018) définit l’intelligence artificielle (IA) comme « l’ensemble des techniques qui permettent à une machine de simuler l’intelligence humaine, notamment pour apprendre, prédire, prendre des décisions et percevoir le monde environnant » (p. 19). La mise en synergie des techniques computationnelles de l’IA, du learning analytics, des données massives et du computer-supported collaborative learning (Rienties et al., 2020) explique les récents développements techniques des systèmes d’intelligence artificielle (SIA), notamment l’apprentissage machine, et particulièrement l’apprentissage profond. Parce qu’ils impliquent une grande quantité de données, une autonomie croissante dans leur traitement et des possibilités éducatives d’envergure, ces derniers sont moteurs dans les développements actuels des SIA-ED, en arrimant des préoccupations transversales de l’IA (p. ex., reconnaître, représenter et interpréter des actions et comportements humains, prendre des décisions, prédire, etc.) à des phénomènes éducatifs (p. ex., réussite scolaire, individualisation des apprentissages, etc.). Plus concrètement, Zawacki-Richter et al. (2019) regroupent les SIA-ED en quatre catégories : 1) le profilage et la prédiction (p. ex., admission à un programme d’études, décrochage) ; 2) les systèmes de tutorat intelligent (p. ex., enseignement de contenus pédagogiques, rétroactions) ; 3) la mesure et l’évaluation (p. ex., notation automatique, évaluation de l’engagement scolaire) ; 4) les systèmes adaptatifs et de personnalisation (p. ex., recommandation et sélection de contenus personnalisés). La multiplication des SIA-ED et les possibilités éducatives qu’ils ouvrent ont entraîné un regain d’intérêt chez les communautés de chercheurs et chercheuses, qui se manifeste à travers le nombre exponentiel de publications scientifiques qui leur sont dédiées depuis la moitié des années 2010, comme en attestent plusieurs recensions d’écrits sur le sujet (Chen et al., 2020 ; Li et al., 2020 ; Zawacki-Richter et al., 2019 ; Zhang & Aslan, 2021). Ce foisonnement scientifique prend principalement la forme d’études appliquées de SIA-ED, c’est-à-dire, du développement et de l’évaluation de SIA-ED ayant le potentiel d’améliorer les pratiques et les processus institutionnels, pédagogiques et d’apprentissage.

Si l’étude appliquée des SIA-ED est prédominante, les enjeux éthiques et critiques qu’ils soulèvent lorsqu’ils sont mis au service de l’institution scolaire, de l’enseignement et de l’apprentissage ont fait l’objet d’une moins grande attention. Encore récemment Zawacki-Richter et al. (2019) notaient dans leur recension systématique des écrits sur l’IA en enseignement supérieur que « a stunningly low number of authors, only two out of 146 articles (1.4 %), critically reflect upon ethical implications, challenges and risks of applying AI in education » (p. 10). À défaut d’être anticipés, ils tendent à apparaître au travers des controverses que suscitent les usages de SIA-ED. Le dernier exemple en date est sans doute l’algorithme A-level développé sous la responsabilité de l’Office of Qualifications and Examinations Regulation (OFQUAL) au Royaume-Uni. Sur le constat que la COVID-19 a perturbé les évaluations des apprentissages de diverses manières, OFQUAL a développé un algorithme visant à corriger la discontinuité des résultats scolaires et leur inflation éventuelle. Cependant, cet algorithme a produit des scores discriminants à l’égard des personnes apprenantes des milieux scolaires défavorisés, menaçant ainsi d’accroître les inégalités scolaires existantes, notamment entre écoles privées et publiques (Hao, 2020).

Bien que la réflexion sur ces questions ait été amorcée dès le début des années 2000 (p. ex., Aiken & Epstein, 2000), on note actuellement un regain d’intérêt des chercheurs et chercheuses pour les enjeux éthiques et critiques des SIA-ED, qui se manifeste de deux façons : d’une part, par l’élaboration de cadres éthiques visant à encadrer la conception, l’implantation et les usages des SIA-ED ; d’autre part, par des recherches empiriques et théoriques étudiant les enjeux éthiques et critiques soulevés par la conception, l’implantation et les usages des SIA-ED. Dans les sections suivantes, nous détaillons ces deux angles d’approche des enjeux éthiques et critiques des SIA-ED tout en montrant leurs limites.

La réflexion sur les enjeux des SIA-ED se traduit en premier lieu par la multiplication de cadres éthiques visant à les identifier pour mieux les gérer. Dans cette perspective, un enjeu éthique se pose « lorsqu’une valeur ou un principe moral est mis en jeu dans une question ou une situation » (Commission de l’éthique en science et en technologies, en ligne1). Les cadres éthiques les plus connus sont sans doute le Consensus de Beijing sur l’intelligence artificielle et l’éducation (UNESCO, 2019), qui identifie 36 mesures, et les Lignes directrices éthiques sur l’utilisation de l’intelligence artificielle et des données dans l’enseignement et l’apprentissage à l’intention des éducateurs (Commission européenne, 2022), qui présente certaines considérations et exigences éthiques et aboutit à des questions et des conseils visant à soutenir la mise en œuvre des SIA-ED dans les systèmes éducatifs. Outre ces cadres éthiques internationaux, s’ajoutent des cadres éthiques à l’initiative d’institutions nationales ou locales (p. ex., Ethical Framework for AI in Education [Institute for Ethical AI in Education, 2020]) ou de compagnies privées (p. ex., les cinq piliers d’une IA responsable de Meta2).

Ces cadres éthiques sont très pertinents dans la mesure où ils permettent de baliser la conception, l’implantation et l’usage des SIA-ED sur la base de valeurs souhaitables (p. ex., le bon, le juste) qui sont éventuellement établies de manière délibérative et située. Ce faisant, ils permettent de reconnaître aux SIA-ED leur dimension axiologique et de rehausser chez les acteurs et actrices des SIA-ED (personnes conceptrices, administratrices scolaires, enseignantes, etc.) la part de responsabilité qui leur incombe, ce à quoi les études appliquées des SIA-ED sont moins attentives.

Toutefois, ces cadres éthiques font face à deux limites principales lorsqu’il s’agit de réfléchir aux enjeux des SIA-ED. La première est qu’en centrant leur attention sur les valeurs dignes d’être poursuivies, c’est-à-dire, sur ce que les SIA-ED devraient ou pourraient être dans des situations éthiquement acceptables, ils font l’impasse sur l’actualisation de ces valeurs dans les contextes et les pratiques effectifs. Or, cette confrontation à l’empirie est nécessaire pour mettre en lumière les rapports de pouvoir plus ou moins inégaux qui peuvent, d’une part, conditionner le choix des valeurs souhaitables, d’autre part, entraver de diverses façons leur mise en œuvre en façonnant inéquitablement la conception, l’implantation et les usages des SIA-ED. En effet, les acteurs et actrices sociaux ne développent pas pareillement leur compétence éthique (Marchildon, 2017), de sorte qu’ils ne sont pas équitablement outillés pour identifier les valeurs à poursuivre dans une situation donnée et faire face aux enjeux qui peuvent surgir de leur non-respect. À titre d’exemple, la mesure 23 du Consensus de Beijing sur l’intelligence artificielle et l’éducation (UNESCO, 2019) recommande « to ensure that AI promotes high-quality education and learning opportunities for all, irrespective of gender, disability, social or economic status, ethnic or cultural background, or geographic location. The development and use of AI in education should not deepen the digital divide and must not display bias against any minority or vulnerable groups » (p. 7). Bien que cette mesure, qui vise l’équité, soit éminemment louable, les rapports sociaux inégaux qui sont à l’origine de la minorisation et de la vulnérabilité de certains groupes scolaires sont les mêmes qui sont susceptibles d’entraver cette valeur lors de la conception, de l’implantation et des usages des SIA-ED, aux dépens des mêmes groupes scolaires minorisés et vulnérables. En somme, ils traitent des enjeux des SIA-ED en dissociant artificiellement les valeurs dignes d’être poursuivies des rapports sociaux dans lesquels elles prennent nécessairement place lors de leur mise en œuvre. Ce faisant, ils font en grande partie l’impasse sur les conditions sociales qui génèrent et actualisent les enjeux des SIA-ED, de sorte qu’ils peinent à anticiper ces derniers.

Une deuxième limite est que ces cadres éthiques, au même titre que les valeurs qu’ils promeuvent et leur mise en œuvre, n’échappent pas aux dynamiques de pouvoir sur lesquels ils font l’impasse. Ils courent alors le risque d’être détournés vers d’autres fins que celle d’ordre éthique. C’est ce que Verdegem (2021) nomme l’ ethics-washing, soit l’instrumentalisation de l’éthique, en premier lieu par l’industrie de l’IA, dans le but d’éviter une régulation politique plus contraignante et imputable. Par exemple, Google s’est doté de sept principes éthiques3 censés guider sa conception de l’IA, alors même que Krutka et al. (2021) documentent comment cette compagnie « extracts personal data from students, skirts laws intended to protect them, targets them for profits, obfuscates the company’s intent in their Terms of Service, recommends harmful information, and distorts students’ knowledge » (p. 1). En ce sens, les cadres éthiques sur les SIA-ED sont assurément nécessaires mais non suffisants : en laissant dans l’ombre les rapports de pouvoir qui sont constitutifs des SIA-ED, ils font l’impasse sur des composantes essentielles des enjeux qu’ils abordent, ces derniers restant tout aussi opératoires, notamment à leurs dépens.

Dans ce contexte, les approches critiques nous semblent complémentaires aux approches éthiques pour aborder les enjeux que suscitent les SIA-ED dans toutes leurs ramifications puisqu’elles font des rapports de pouvoir un point focal de leur analyse (de Munck, 2011 ; Granjon, 2015). En effet, les approches critiques postulent que les rapports entre groupes sociaux sont historiquement fondés et inégaux à divers degrés. Elles sont donc attentives aux rapports de pouvoir qui façonnent le choix et la mise en œuvre des valeurs dignes d’être poursuivies jusque dans le quotidien scolaire. Pour cette raison, nous privilégions dans cet article le terme « enjeux éthiques et critiques ». Ce dernier ne signifie pas qu’il y aurait, d’un côté, des enjeux qui relèveraient de l’éthique et, de l’autre, ceux qui concernerait la critique : plusieurs enjeux des SIA-ED peuvent recouper les deux dans des configurations diverses (notamment en fonction des traditions éthiques et critiques mobilisées) de sorte qu’il nous semblerait à la fois vain et contre-productif de chercher à les dissocier. Plutôt, le terme « enjeux éthiques et critiques » est employé pour couvrir toutes leurs déclinaisons. Aussi, dans le cadre de ce texte, les enjeux éthiques et critiques renvoient autant aux valeurs morales mises en jeu dans une situation (ce qui correspond à la définition d’un enjeu éthique par la Commission de l’éthique en science et en technologie, voir plus haut), qu’aux rapports de pouvoir qui sont susceptibles de façonner le choix de ces valeurs et d’entraver leur mise en œuvre (ce que les approches critiques permettent d’ajouter).

Outre l’élaboration de cadres éthiques, l’intérêt montant pour les enjeux éthiques et critiques des SIA-ED se traduit aussi par la production de travaux scientifiques, d’ordre théorique ou empirique, qui les prennent comme objet d’étude. Ces travaux sont relativement récents et semblent en plein essor4. Il est toutefois difficile d’avoir une vue synthétique des enjeux éthiques et critiques qu’ils discutent car les objets d’étude et les angles d’analyse varient grandement. Ils peuvent porter sur des ordres d’enseignement spécifiques (p. ex., l’enseignement supérieur) ou être généraux. Ils peuvent également se focaliser sur des techniques computationnelles particulières, qui induisent des enjeux éthiques et critiques spécifiques, ou traiter de tous les SIA-ED confondus. Il en ressort un portrait relativement fragmenté. Or, à notre connaissance, aucune revue de la littérature n’a porté spécifiquement sur les enjeux éthiques et critiques des SIA-ED, alors même que les connaissances ont progressivement été enrichies ces dernières années et que certaines revues de la littérature (Zawacki-Richter et al., 2019 ; Zhang & Aslan, 2021) concluent à la nécessité d’une plus grande considération des enjeux éthiques et critiques. Aussi, l’objectif de cet article est de mener une revue systématique de la littérature sur les enjeux éthiques et critiques des SIA-ED afin d’en avoir un meilleur portrait.

Nous avons opté pour une recension systématique des écrits, qui constitue la « méthode la plus valide et la plus fiable pour repérer et synthétiser les connaissances existantes » (Landry et al., 2009, p. 3). Pour ce faire, nous avons commencé par définir une question initiale de recherche : quels sont les enjeux éthiques et critiques des SIA-ED? Nous avons ensuite décliné cette question sous forme de mots-clés assortis de critères d’inclusion et d’exclusion (Tableau 1) pour interroger des bases de données spécialisées (Dimensions, Open Editions, PsycInfo, Web of science, EBSCO, Science direct, ACM Digital Library, et IEEE Digital Library) et génériques (Google Scholar, Microsoft Academic, et Open Editions). Faute de compétences plurilingues élargies, nous nous en sommes tenus aux textes rédigés en français ou en anglais.

Nous avons complété cette recherche documentaire linéaire par une recherche documentaire par sérendipité, en repérant dans les bibliographies des documents consultés les références qui répondaient globalement aux critères de la recherche documentaire linéaire mais qui n’étaient pas ressortis initialement. À titre d’exemple, l’article de Aiken et Epstein (2000) ne faisait pas initialement partie du corpus de textes dans la mesure où il ne respecte pas le critère de la date de publication (Tableau 1). Toutefois, sa grande popularité au sein de notre corpus de texte nous a amené à le prendre en compte de façon exceptionnelle lors de la recherche documentaire par sérendipité. Nous avons ainsi pu recouper et bonifier la recherche documentaire linéaire en ajoutant quelques textes fréquemment cités dans la littérature scientifique.

Tableau 1

Critères d’inclusion et d’exclusion

| Critères d’inclusion automatique | |

| Critères | Valeurs |

| Langue | Anglais ou français |

| Doit aborder l’intelligence artificielle | Titre ou résumé contient « intelligence artificielle » (ou équivalents anglais) |

| Doit aborder l’éducation | Titre ou résumé contient « éducation » ou « enseign* » ou « appren* » (ou équivalents anglais) |

| Doit aborder l’éthique ou la critique | Titre ou résumé contient « éthique » ou « critique » (ou équivalents anglais) |

| Date de publication | 2010-2021 |

| Critères d’exclusion manuelle (balayage titres et résumés) | |

| Enjeux éthiques et critiques mentionnés de façon superficielle au sein d’un texte | |

| Documents évoquant des enjeux éthiques et critiques en référence à d’autres textes (p. ex., éditoriaux qui introduisent les articles d’un numéro thématique) | |

Les recherches documentaires linéaires et par sérendipité se sont déroulées fin juin et début juillet 2021. Elles ont été effectuées par deux étudiants (maîtrise et doctorat) sous la supervision du premier auteur de cet article. La recherche documentaire brute a permis de repérer 206 résultats. Après application de ces critères, 58 documents ont été retenus pour analyse.

Sur la base de ce corpus de textes, nous avons adopté une démarche d’analyse qualitative émergente (Corbin & Strauss, 2008). Tous les documents du corpus final ont été lus et les passages relatifs aux enjeux éthiques et critiques ont été codés au moyen du logiciel d’analyse qualitative NVivo 12. Les premiers textes ont chacun été analysés par deux membres de l’équipe de façon individuelle, qui se rencontraient ensuite sous la supervision du premier auteur de cet article pour confronter et arrimer leur codage et faire évoluer la grille de codes en conséquence. Cette démarche itérative a permis d’une part, d’éprouver la grille de codes, d’autre part, d’éprouver l’interprétation des codes par chacun des membres de l’équipe. Après une dizaine de textes, cette démarche a permis d’aboutir à une compréhension partagée et une stabilisation de la grille de codes autour de 70 enjeux éthiques et critiques, qui a pu être appliquée au reste du corpus.

Dans un deuxième temps, nous avons construit un système de sens à partir des enjeux éthiques et critiques identifiés. C’est, selon Corbin et Strauss (2008), l’étape de l’intégration des concepts. Pour ce faire, nous avons regroupé les codes par thèmes selon la proximité de sens qu’ils entretenaient entre eux. Ce travail de thématisation s’est effectué conjointement à un travail de dénomination durant lequel nous avons cherché à désigner le plus précisément possibles les ensembles thématiques qui émergeaient. Après plusieurs itérations et l’évaluation critique d’un chercheur et d’une chercheuse externes au projet, le système de sens auquel nous avons abouti a été stabilisé en six regroupements principaux que nous avons identifiés comme des tensions (voir section « Résultats »).

Quelques considérations méthodologiques s’imposent afin d’apprécier les apports, mais aussi les limites, de cette revue systématique de la littérature. La première tient au fait que la littérature scientifique sur les enjeux éthiques et critiques des SIA a connu un essor fulgurant depuis la dernière décennie dans plusieurs secteurs (Bruneault et al., 2022), alors qu’elle s’est constituée plus tardivement en éducation. Malgré tout, nous avons choisi de nous restreindre au secteur éducatif, notre objectif n’étant pas d’identifier des enjeux éthiques et critiques d’un point de vue intersectoriel, mais plutôt d’apprécier leur déclinaison singulière en éducation.

Une deuxième limite a trait à la diversité des documents analysés. Comme mentionné plus haut (voir section « Les études théoriques et empiriques sur les enjeux des SIA-ED »), ces derniers couvrent des terrains éducatifs, des techniques computationnelles et des angles d’analyse variés, ce qui résulte en un portrait fragmenté des enjeux éthiques et critiques des SIA-ED. Notre objectif étant d’en fournir une vue synthétique, nous n’avons pas restitué cette hétérogénéité éducative et technique dans le cadre de nos résultats, au risque d’en proposer une lecture décontextualisée.

Le système de sens auquel nous avons abouti s’articule autour de tensions, desquelles découlent des enjeux éthiques et critiques. Une tension correspond à une relation entre un SIA-ED et un aspect éducatif qui peut potentiellement devenir problématique si le premier interfère avec les valeurs, les finalités, les situations et les pratiques du second. Une tension n’est donc pas une discordance, mais elle peut le devenir si un SIA-ED n’est pas anticipé et orienté à l’aune des conditions et des exigences propres à l’éducation. En ce sens, une tension est toujours porteuse d’enjeux éthiques et critiques. Comme établi plus haut (voir section « Les cadres éthiques »), ces derniers sont définis comme les valeurs morales mises en jeu dans une situation, ainsi que les rapports de pouvoir qui sont susceptibles de façonner le choix de ces valeurs et d’entraver leur mise en œuvre. Au même titre que les tensions dont ils découlent, les enjeux éthiques et critiques sont d’abord potentiels. Ils ne deviennent effectifs que lorsque la relation entre un SIA-ED et l’éducation devient elle-même problématique. À titre d’exemple, le fait qu’un système de prédiction du risque de décrochage scolaire commette des erreurs de prédiction constitue un enjeu potentiel. Ce dernier devient effectif s’il commet un grand nombre d’erreurs (auquel cas il n’est pas fiable) ou si les erreurs, même en quantité limitée, sont plus fréquentes auprès de certaines populations d’apprenants et d’apprenantes (p. ex., ceux issus de milieux défavorisés), auquel cas il s’agit d’un biais qui peut engendrer des discriminations envers ces populations.

Les six tensions identifiées (Figure 1) sont de divers ordres. Certaines renvoient à des dimensions ontologiques de l’humain et de la technique (complexité des situations éducatives vs standardisation technique ; agentivité des acteurs et actrices scolaires vs automatisation technique). D’autres sont davantage de nature politique (justice scolaire vs rationalité technique ; gouvernance scolaire vs conception technique). D’autres encore renvoient à des considérations morales (besoin d’intelligibilité des acteurs et actrices scolaires vs opacité technique ; dignité des acteurs et actrices scolaires vs exploitation des données). En outre, ces tensions couvrent un nombre variable d’enjeux éthiques et critiques. Avec 22 enjeux, la tension « dignité des acteurs et actrices scolaires vs exploitation des données » est la plus représentée, suivie des tensions « justice scolaire vs rationalité technique » (17 enjeux), « gouvernance scolaire vs conception technique » (10 enjeux), « besoin d’intelligibilité des acteurs et actrices scolaires vs opacité technique » et « agentivité des acteurs et actrices scolaires vs automatisation technique » (8 enjeux chacune), et finalement, « complexité des situations éducatives vs standardisation technique » (5 enjeux).

Figure 1

Six tensions des SIA-ED en éducation

Pour présenter ces tensions et les enjeux qui en découlent, nous commençons par introduire chaque tension, puis nous présentons les enjeux qui lui sont associés. Nous donnons d’abord un aperçu de ces derniers au moyen d’un tableau indiquant pour chacun d’eux le nombre de documents qui l’ont mentionné, le nombre de segments codés qui s’y réfèrent et les textes qui en sont les plus représentatifs (quant au nombre de passages codés)5. Pour creuser le sens et les relations entre les enjeux d’une tension, nous en proposons ensuite une description textuelle en distinguant ceux qui apparaissent davantage lors de la conception et ceux qui surgissent plutôt lors des usages des SIA-ED par les acteurs et actrices scolaires. Bien que cette division entre conception et usage soit commode pour rendre compte des enjeux éthiques et critiques, nous les concevons comme un seul et même processus d’innovation technique, à l’instar des études du Social Shaping of Technology (p. ex., MacKenzie & Wacjman, 1985).

La première tension met en relation la complexité des situations éducatives et la standardisation des SAI-ED et soulève le risque qu’un SIA-ED fournisse aux acteurs et actrices scolaires des informations décontextualisées et simplistes à propos des situations éducatives qu’ils et elles vivent, alors que ces situations prennent sens de manière située. Contrairement à la conception technique artisanale, qui permet d’aménager le processus de conception pour l’adapter aux besoins de chaque usager et usagère, l’IA (à l’instar des techniques industrielles) implique une standardisation de ses techniques computationnelles, et donc une standardisation des usages qu’elle propose. Cette standardisation des usagers et usagères fait écho au principe de la « personne usagère universelle » (user as everybody, Oudshoorn et al., 2004), suivant lequel une équipe de conception tend à homogénéiser la représentation qu’elle se fait des usagers et usagères visés, en les ramenant à une personne usagère archétypale. Ce faisant, elle perd de vue la diversité des usagers et usagères réels et de leurs contextes (Oudshoorn et al., 2016).

En éducation, mêmes les cas de personnalisation des apprentissages proposés par les SIA-ED n’échappent pas à cette tendance. Par exemple, l’apprentissage adaptatif, dont l’objectif est précisément de dépasser le one size fits all en individualisant le soutien qu’il offre aux personnes apprenantes, résulte d’algorithmes qui ont été standardisés lors de la phase de conception et qui appliquent donc des standards lors de l’usage. Il s’agit d’une individualisation standardisée sur la base de modèles prédéfinis lors de la conception des SIA-ED, ce qui signifie qu’elle opère sur des marqueurs d’individualisation inscrits dans les algorithmes, en ignorant ceux qui n’y ont pas été inclus. De cette tension entre la complexité des situations éducatives et la standardisation de l’IA découlent plusieurs enjeux éthiques et critiques.

Tableau 2

Récapitulatif des enjeux associés à la tension « complexité des situations éducatives — standardisation technique »

| Enjeux | Documents | Segments | Principaux articles |

| Diminution de la prise en compte du contexte éducatif | 14 | 23 | Hakimi et al. (2021). Prinsloo et Slade (2017, mars). Romero (2019). |

| 25 | 40 | Corrin et al. (2019). Perrotta et Selwyn (2020). Selwyn et Gašević (2020). Zeide (2019). |

| 6 | 9 | Holmes et al. (2022). Perrotta et Selwyn (2020). Romero (2019). |

| Industrialisation de l’éducation | 24 | 54 | Davies et al. (2021). Hakimi et al. (2021). McStay (2020). |

| 7 | 11 | Holstein et Doroudi (2021). |

Processus de conception — Certains auteurs et autrices soulignent que le processus de conception d’un SIA-ED peut s’accompagner d’une diminution de la prise en compte des caractéristiques d’une situation éducative, qui sont pourtant déterminantes pour intervenir de manière avisée. Le processus de conception peut se traduire par une réduction superficielle de la complexité d’une situation éducative à cause des données utilisées pour la documenter. Il existe par exemple des algorithmes de clustering qui, à partir des performances des personnes apprenantes dans un exercice, proposent aux acteurs et actrices scolaires des groupes de niveaux. On ne met cependant aucune information contextuelle à disposition de ces algorithmes pour procéder à cette évaluation. Une personne apprenante qui, pour une raison exceptionnelle, raterait son exercice ce jour-là serait donc automatiquement classé à la baisse par l’algorithme sans que sa performance atypique ne soit traitée.

Processus d’usage — La réduction superficielle de la complexité éducative lors du processus de conception peut également se manifester sur le plan des usages, lorsque les acteurs et actrices scolaires font une interprétation simpliste des résultats d’un SIA-ED.

Pour certains auteurs et autrices, ces enjeux de conception et d’usage participent d’une industrialisation de l’éducation, avec comme contre-effet possible un manque d’adaptabilité des SIA à la diversité des milieux éducatifs, ce qui s’inscrit en porte-à-faux avec les promesses d’individualisation de l’éducation.

Une deuxième tension met en relation l’agentivité des acteurs et actrices scolaires (entendue dans le sens de « pouvoir d’agir », Le Bossé, 2003) et l’automatisation des SIA-ED et soulève le risque qu’un SIA-ED empiète sur le jugement et les interventions professionnelles des acteurs et actrices scolaires. Cette tension n’est pas nouvelle ; elle est d’abord apparue dans la relation entre l’ouvrier et la machine lors de la révolution industrielle au 18e siècle. Plus précisément, elle est née du remplacement de la force humaine par la force mécanique comme moteur du travail, comme le souligne Marx (1867/2020) : « Dans la manufacture et le métier, l’ouvrier se sert de son outil ; dans la fabrique, il sert la machine. Là, le mouvement de l’instrument de travail part de lui ; ici, il ne fait que le suivre » (p. 287). Depuis la révolution industrielle, l’automatisation technique s’est prolongée de la sphère de la production à celle de la consommation. Les développements techniques récents ont décuplé l’automatisation des biens et des services à destination des personnes usagères, ce qui implique que les choix d’usage d’un SIA sont de plus en plus conditionnés par les équipes de conception en amont des usagers et usagères.

Tableau 3

Récapitulatif des enjeux associés à la tension « agentivité des acteurs et actrices scolaires — automatisation technique »

| Enjeux | Documents | Segments | Principaux articles |

| Déplacement du locus décisionnel | 20 | 25 | Holmes et al. (2022). Hrastinski et al. (2019). Polonetsky et Tene (2014). Shum et Luckin (2019). |

| 9 | 9 | Lu et al. (2021). |

| Limitation des choix et des actions | 5 | 6 | Hakimi et al. (2021). |

| 23 | 42 | Holmes et al. (2022).Schiff (2021). Shum et Luckin (2019). Smuha (2020). |

| 14 | 17 | Smuha (2020). |

| 4 | 6 | Regan et Jesse (2019). Remian (2019). |

| 15 | 19 | Corrin et al. (2019). Roberts et al. (2017). Romero (2019). Williamson et al. (2020). |

| Diminution de l’agentivité des acteurs et actrices scolaires | 32 | 67 | Corrin et al. (2019). Holmes et al. (2022). |

Processus de conception — Certains auteurs et autrices soulignent que les SIA-ED sont capables de prendre en charge une partie croissante des tâches d’une situation éducative, ce qui implique que des choix pédagogiques de plus en plus signifiants sont effectués dès le processus de conception. En fonction des choix pédagogiques effectués dès lors, un SIA-ED peut entraîner un déplacement du locus décisionnel, par exemple : en imposant des formules et des contenus éducatifs dont le choix relève habituellement du personnel scolaire ; en omettant des mécanismes d’appel des résultats d’un SIA-ED lorsque les acteurs et actrices scolaires jugent ces derniers douteux ; ou encore, en utilisant des chambres d’écho6 qui amplifient les tendances manifestées par un acteur ou une actrice scolaire et obstruent d’autres tendances possibles qu’il et elle pourrait juger pertinentes, bien qu’elle ne les ait pas anticipées. On pense par exemple à des SIA-ED telles que les systèmes de recommandation de contenus (tuteurs intelligents), qui ne permettent pas toujours aux acteurs et actrices scolaires d’intervenir dans la planification du parcours d’apprentissage des personnes apprenantes. Poussant le déplacement du locus décisionnel à l’extrême, certains auteurs et autrices y voient les signes avant-coureurs d’un remplacement des acteurs et actrices scolaires par les SIA-ED, même si cela semble peu probable dans l’état actuel des connaissances scientifiques.

Processus d’usage — L’enjeu principal relevé par les auteurs et autrices sur le plan des usages est une diminution de l’agentivité des acteurs et actrices scolaires par limitation de leurs choix et de leurs actions professionnelles. Certaines de ces limitations peuvent être davantage inconscientes. C’est le cas lorsqu’une acteur ou une actrice scolaire développe une perception déterministe des prédictions produites par l’IA, à partir desquelles il et elle fixe ses horizons d’attente. Par exemple, le fait qu’une personnes apprenante soit étiquetée comme étant à risque élevé de décrochage scolaire par un SIA-ED peut « cimenter » le jugement professionnel de la personne enseignante et diminuer insidieusement le attentes de cette dernière en matière de réussite scolaire. Cette perception déterministe est d’autant plus probable lorsque les acteurs et actrices scolaires ne comprennent pas le fonctionnement d’un SIA-ED, notamment lorsque ce dernier est opaque (voir tension « besoin d’intelligibilité des acteurs et actrices scolaires vs opacité »).

Cette troisième tension entre la justice scolaire et la rationalité technique pointe le risque qu’un SIA-ED naturalise des situations d’injustice subies par des groupes éducatifs minorisés en les inscrivant dans la matérialité de son fonctionnement technique. Cette tension repose sur le postulat de départ que la technique n’est pas neutre. Elle véhicule des valeurs et des normes sociales qui sont inscrites dans ses propriétés techniques durant la conception et qu’elle prescrit aux personnes usagères lorsque ces dernières l’utilisent (Akrich, 1987). Or, la rationalité technique amène les équipes de conception à faire l’impasse sur les dimensions axiologiques des SIA en se concentrant exclusivement sur leurs dimensions techniques, abordées par exemple en ce qui a trait à l’efficacité, la précision et la performance. Ce faisant, elles ont toutes les chances de prendre pour étalon de référence les normes sociales dominantes, et ainsi de contribuer à les naturaliser, aux dépens de normes, tout aussi légitimes, de groupes sociaux minorisés (Oudshoorn, 2004). Au même titre que la technique dans son ensemble, les SIA-ED correspondent donc à la « matérialisation de rapports sociaux » (Roqueplo, 1983, p. 31) et véhiculent ainsi des logiques de domination ou, au contraire, d’émancipation, qui leur ont donnés forme.

Tableau 4

Récapitulatif des enjeux associés à la tension « justice scolaire — rationalité technique »

| Enjeux | Documents | Segments | Principaux articles |

| Recherche démesurée de l’efficacité pédagogique, organisationnelle ou financière | 29 | 47 | Karumbaiah et Brooks (2021, mai). Kitto et Knight (2019). Prinsloo et Slade (2017, mars). Remian (2019). Zeide (2019). |

| 32 | 59 | Holmes et al. (2022). McStay (2020). Reiss (2021). Smuha (2020). |

| 16 | 42 | Regan et Jesse (2019). |

| 3 | 12 | Remian (2019). Restrepo et al. (2019). |

| 17 | 53 | Kizilcec et Lee (2022). Marras et al. (2022). Scholes (2016). |

| 9 | 15 | Madaio et al. (2021). |

| Utilisation de données contenant des biais humains | 6+21 | 7+34 | Kizilcec et Lee (2022). |

| 21 | 43 | Kizilcec et Lee (2022). |

| 1 | 2 | Meaney et Fikes (2019, mars). |

| 4 | 6 | Meaney et Fikes (2019, mars). |

| Interprétation des données teintées par des préjugés humains | 8 | 9 | Hakimi et al. (2021). |

| Hégémonie ethnoculturelle | 11 | 21 | Karumbaiah et Brooks (2021, mai). Mayfield et al. (2019, août). Schiff (2021). |

| 5 | 9 | Mayfield et al. (2019, août). Pinkwart (2016). |

| 3 | 3 | Holstein et Doroudi (2021). Pinkwart (2016). |

| 1 | 3 | Karumbaiah et Brooks (2021, mai). |

| Discrimination des personnes | 25 | 48 | Kizilcec et Lee (2022). Madaio et al. (2021). |

| 10 | 11 | Madaio et al. (2021). |

Processus de conception — Plusieurs auteurs et autrices pointent que les SIA-ED sont souvent conçus dans des visées exclusives d’efficacité pédagogique (p. ex., apprentissages plus performants), organisationnelle (p. ex., meilleure gestion du temps et des tâches) ou financière (p. ex., réduction des coûts) et qu’elles sont conçues par des équipes de conception sociodémographiquement homogènes et socioéconomiquement privilégiées, donc peu sensibles aux disparités éducatives qui vont ultérieurement teinter un SIA-ED lors de ses usages par les milieux scolaires. Ainsi, des considérations éducatives importantes, telles que le bien-être des acteurs et actrices scolaires, et plus généralement l’équité, la diversité et l’inclusion de groupes éducatifs spécifiques (p. ex., apprenants et apprenantes à besoins particuliers), peuvent passer au second plan des préoccupations des équipes de conception. Prenons l’exemple d’un système de traitement du langage qui a la capacité d’évaluer les processus de rédaction des apprenants à partir de l’analyse des frappes des touches du clavier. Les apprenants et apprenantes malvoyants, qui privilégient une saisie orale de leur texte (fonction speech-to-text), sont exclus d’un tel SIA-ED. Ce manque de considération pour les enjeux de justice scolaire peut donc induire des biais algorithmiques produits par les équipes de conception, en plus de biais éventuellement présents dans les données utilisées pour entraîner un SIA-ED. Sur ce point, certains auteurs et autrices rapportent que les données peuvent sous-représenter certains groupes éducatifs ou en surreprésenter d’autres (p. ex., personnes apprenantes performantes; personnes utilisatrices précoces d’un SIA-ED).

C’est également le cas d’un point de vue interculturel, où un SIA-ED peut sous-représenter des cultures différentes de celles dans lesquelles il est utilisé. Par exemple, les techniques computationnelles liées au traitement de la langue (natural language processing) sont très souvent performantes en anglais, langue pour laquelle de nombreuses librairies et jeux de données existent, mais deviennent impossibles à développer ou sous-performent dans des langues moins utilisées, menant à une disparité de SIA-ED en fonction des cultures.

Processus d’usage — Plusieurs auteurs et autrices rapportent que les enjeux mentionnés ci-dessus peuvent mener à la discrimination de certains groupes éducatifs et à l’exacerbation des inégalités numériques. De manière plus tangible, ces enjeux de biais sociaux, de discrimination et d’inégalités numériques peuvent prendre la forme d’interfaces moins facile d’accès ou d’une baisse de performance d’un SIA-ED (p. ex., reconnaissance faciale moins performante pour des groupes éducatifs à la couleur de peau foncée ; dysfonctionnement accru pour certaines langues) pour certains groupes éducatifs. S’ajoute aussi des biais sociaux possibles des acteurs et actrices scolaires lorsqu’ils et elles interprètent les résultats d’un SIA-ED. Par exemple, un SIA-ED destiné à faciliter la communication école-famille pourrait révéler que les parents issus de milieux multiethniques et défavorisés répondent moins aux messages envoyés par l’École. Devant ce constat, un acteur ou un actrice scolaire pourrait conclure qu’ils sont désengagés, alors que d’autres facteurs, tels que le manque d’accès et de compétence numériques ou la faible maîtrise de la langue de scolarisation de leur enfant, peuvent être en cause.

Cette quatrième tension soulève le risque que des acteurs et actrices, des logiques et des produits (notamment commerciaux) interfèrent avec les finalités et la gestion du bien public qu’est l’éducation. Cette tension trouve son origine dans un clivage historique supposé entre le domaine technique et le domaine politique (Law, 1991). Relevant du premier, la conception de l’IA dépendrait principalement des organisations scientifiques et économiques, notamment de compagnies privées, et serait l’affaire d’experts de la technique (informaticiens, ingénieurs, etc.). Au contraire, l’éducation appartiendrait au domaine politique, lequel impliquerait des institutions publiques et des acteurs et actrices politiques et sociaux, incluant les citoyens et citoyennes. Se pose alors la question de l’intégration, dans la gouvernance d’un bien commun (l’éducation), d’un phénomène (les SIA-ED) qui n’a pas le statut d’un bien public. Cet enjeu est d’autant plus important dans le cas de l’apprentissage machine non supervisé, pour lequel la tentation est forte de le considérer comme une technique computationnelle neutre et anodine. En effet, « les concepteurs pourraient se dégager — dans une certaine mesure — de la responsabilité, puisqu’ils ne font que fabriquer un dispositif apprenant, en quelque sorte, une boîte vide » (Métais, 2018, p. 62).

Tableau 5

Récapitulatif des enjeux associés à la tension « gouvernance scolaire — conception technique »

| Enjeux | Documents | Segments | Principaux articles |

| Absence de cadre éthique ou manque de précision dans les principes éthiques utilisés | 15 | 45 | Kitto et Knight (2019). |

| 33 | 74 | Regan et Jesse (2019). Remian (2019). Smuha (2020). |

| 2 | 2 | Holmes et al. (2022). Wintrup (2017). |

| 9 | 23 | Roberts et al. (2017). |

| Ambiguïté quant à la propriété des données et des SIA-ED | 17 | 40 | Aiken et Epstein (2000). Berendt et al. (2020). Lawson et al. (2016). |

| 15 | 22 | Saltman (2020). |

| 8 | 11 | Rubel et Jones (2016). |

| Mauvaise gouvernance ou absence de gouvernance spécifique aux SIA-ED | 7 | 17 | Roberts et al. (2017). |

| 36 | 62 | Holmes et al. (2022). Roberts et al. (2017). Smuha (2020). Southgate (2020). |

| 6 | 12 | Roberts et al. (2017). Smuha (2020). |

Processus de conception — Les enjeux découlant de cette tension concernent l’encadrement de la conception des SIA-ED. Ainsi, plusieurs auteurs et autrices soulèvent une absence de cadre éthique ou un manque de précision des cadres éthiques en vigueur pour baliser convenablement la conception des SIA-ED et la responsabilité morale des équipes de conception, notamment en cas d’erreurs ayant des conséquences importantes ; par exemple, dans le cas de prédictions erronées de réussite ou d’échec ou encore d’erreurs de classification pour des décisions d’admission dans des programmes scolaires. Le même constat vaut sur le plan légal, où plusieurs auteurs et autrices notent une absence de cadre légal ou un manque de précision dans les lois disponibles, notamment parce que ces dernières n’ont pas été actualisées au cas spécifique des SIA-ED. À titre d’exemple, les lois sur la propriété des données s’avèrent ambiguës lorsqu’elles sont appliquées à certains SIA-ED dans lesquels les données sont produites par les acteurs et actrices scolaires mais traitées par les SIA-ED.

Processus d’usage — Les mêmes ambiguïtés s’appliquent au niveau des acteurs et actrices scolaires dans leur implantation et leurs usages des SIA-ED. Ainsi, certains auteurs et autrices relèvent un manque de clarté relatif à la responsabilité morale et légale des institutions et des acteurs et actrices scolaires. Un acteur ou une actrice scolaire est-il ou elle responsable des choix pédagogiques faits par un SIA-ED, par exemple dans le cas de contenus erronés ou présentant des biais culturels indésirables? Jusqu’à quel point doit-il ou elle connaître les (micro)décisions qui peuvent être prises par un SIA-ED, que ce soit pour l’évaluation, la rétroaction ou l’adaptation? Des auteurs et autrices appellent aussi à préciser les politiques d’accès aux données, lesquelles devraient présenter un niveau de granularité permettant à la bonne personne d’accéder aux bonnes données et au bon moment, ni plus ni moins. À titre d’exemple, si une direction d’école peut vouloir consulter un SIA-ED de prédiction du risque de décrochage scolaire des apprenants et apprenantes de son école sur l’ensemble de leur scolarité, une personne enseignante gagnerait sans doute à consulter la prédiction de risque de décrochage de ses apprenants et apprenantes uniquement sur l’année scolaire où elle intervient auprès d’eux, afin de ne pas influencer outre mesure le jugement qu’elle porte sur eux.

Les enjeux de conception et d’usage mentionnés ci-dessus sont associés à d’autres, en premier lieu, celui d’une gouvernance inadéquate des SIA-ED en éducation. Cette dernière peut s’exprimer par un manque d’imputabilité des acteurs et actrices en cas de faute, tant au niveau de la conception que de l’usage d’un SIA-ED. Ce manque d’imputabilité est exacerbé lorsqu’un trop grand nombre d’acteurs et actrices a accès aux données collectées par un SIA-ED, car la responsabilité est alors diffuse. Une manifestation inverse d’une gouvernance inadéquate des SIA-ED correspond à une concentration du pouvoir entre les mains de quelques acteurs et actrices (ceux et celles qui ont accès aux résultats d’un SIA-ED, p. ex., les personnes conceptrices ou les administrateurs et administratrices scolaires), alors que la distribution du pouvoir impliquait auparavant une plus grande collégialité entre les différents acteurs et actrices concernés. Cet enjeu peut mener à une gouvernance non concertée des SIA-ED, notamment en imposant un SIA-ED aux acteurs et actrices scolaires.

En automatisant les SIA-ED, les équipes de conception les autonomisent en partie, dans le sens où elles les soustraient partiellement à l’intelligibilité des acteurs et actrices scolaires, avec le risque qu’un SIA-ED entrave la possibilité pour les acteurs et actrices scolaires d’en évaluer la pertinence éducative. Cette tension fait écho à la métaphore de la « boîte noire », soit le fait, pour un objet technique stabilisé, d’invisibiliser a posteriori tous les choix, les compromis, les négociations et les ambivalences qui ont marqué son processus de conception, sous couvert d’une cohérence et d’une évidence qu’il n’a jamais eues (Akrich, 1987). Cette opacité technique initiale peut être amplifiée par les SIA-ED sur deux plans. D’une part, certaines techniques computationnelles qu’ils impliquent peuvent être difficiles à retracer du fait de leur autonomie relative (voir, p. ex., apprentissage non supervisé, Métais, 2018). Dans ce cas, les SIA-ED sont capable de générer des décisions et des prédictions sans que ces dernières ne reposent sur un modèle explicatif, c’est-à-dire, un modèle qui soit intelligible, donc sujet à débat. D’autre part, même lorsque le processus est explicable, les SIA-ED peuvent manquer de transparence, notamment pour des raisons de concurrence commerciale. Cette opacité des SIA-ED à l’étape de conception se poursuit lors de l’usage, les usagers étant alors réduits à faire confiance aux SIA-ED à défaut de pouvoir les comprendre.

Tableau 6

Récapitulatif des enjeux associés à la tension « besoin d’intelligibilité des acteurs et actrices scolaires — opacité technique »

| Enjeux | Documents | Segments | Principaux articles |

| Manque de transparence quant à la présence de l’IA | 14 | 20 | Nichols et Holmes (2018, octobre). Remian (2019). Southgate (2020). |

| Manque de transparence sur les données utilisés | 28 | 71 | Corrin et al. (2019). Lawson et al. (2016). |

| Manque de transparence quant à l’interprétation et l’usage des résultats | 14 | 24 | Corrin et al. (2019). Holmes et al. (2022). Lawson et al. (2016). Roberts et al. (2017). Zeide (2019). |

| 22 | 50 | Southgate (2020). |

| 22 | 54 | Qin et al. (2020). |

| 8 | 8 | Knox (2017). Shum et Luckin (2019). |

| Manque de preuves d’efficacité pédagogique | 15 | 28 | Bulger (2016). Corrin et al. (2019). |

| 7 | 11 | Holmes et al. (2022). Madaio et al. (2021). McStay (2020). Smuha (2020). |

Processus de conception — Plusieurs auteurs et autrices mentionnent qu’il peut être difficile pour une équipe de conception d’expliquer la logique derrière les résultats obtenus par un SIA-ED surtout lorsque l’apprentissage non supervisé est utilisé. À cette absence d’explicabilité peut s’ajouter un manque de transparence, qui peut se décliner à plusieurs niveaux : manque de transparence sur la présence d’un SIA-ED (p. ex., robot conversationnel), par exemple lorsqu’il est intégré à un service éducatif en ligne sans en aviser les usagers et usagères, voire en tentant de les duper ; manque de transparence sur les données utilisées, comment elles sont utilisées et pourquoi il est nécessaire de les utiliser.

Processus d’usage — Le manque de transparence peut aussi se prolonger lors de l’usage d’un SIA-ED, notamment si l’interprétation que les acteurs et actrices scolaires font des résultats d’un SIA-ED — et les interventions qui en résultent — n’est pas explicitée aux personnes apprenantes ou à leurs parents. Certains auteurs et autrices notent qu’un manque de transparence d’un SIA-ED, couplé à un faible niveau de littératie en IA, peut susciter deux réactions inverses chez les acteurs et actrices scolaires. D’un côté, certains peuvent s’en méfier et refuser de l’utiliser, même s’il pourrait être bénéfique à certains égards. Au contraire, d’autres peuvent avoir une confiance aveugle en un SIA-ED et ne pas remettre en question les décisions qu’il prend ou qu’il suggère, même lorsque celles-ci peuvent avoir des conséquences indésirables, par exemple dans le cas de processus d’évaluation des apprentissages ou d’admission à des programmes scolaires. Ce défaut d’intelligibilité des acteurs et actrices scolaires est d’autant plus problématique lorsqu’un SIA-ED, en plus d’être opaque, n’est pas appuyé sur des preuves de son efficacité pédagogique du point de vue de la réussite scolaire, de l’engagement ou de la satisfaction vis-à-vis des expériences d’apprentissage. Il peut alors amener une acteur ou une actrice scolaire à utiliser un SIA-ED alors même qu’il ou elle n’en perçoit pas clairement l’utilité pédagogique.

L’opacité qui entoure l’IA rend d’autant plus saillante une sixième tension, régulièrement publicisée dans les médias, qui suscite le risque qu’un SIA-ED porte atteinte à la dignité des acteurs et actrices scolaires en ayant des conséquences négatives sur leur personne, par exemple en les manipulant ou en détournant leurs informations vers d’autres finalités que des finalités éducatives. En effet, les développements actuels les plus prometteurs des SIA (p. ex., apprentissage machine) reposent sur la collecte, le traitement et l’interprétation d’un nombre massif de données, ces dernières constituant un aspect de plus en plus fondamental de leur fonctionnement. À ce titre, une mauvaise utilisation, une utilisation déficiente ou une usurpation des données ont été à l’origine de plusieurs controverses sociotechniques ces dernières années, la plus aiguë étant sans doute suscitée par Cambridge Analytica dans le cadre des élections présidentielles américaines de 2016. Se pose alors la question du consentement libre et éclairé des personnes usagères lors de la collecte, du traitement et de l’interprétation des données, particulièrement lorsque les finalités poursuivies par l’exploitation des données sont commerciales.

Tableau 7

Récapitulatif des enjeux associés à la tension « dignité des acteurs et actrices scolaires — exploitation des données »

| Enjeux | Documents | Segments | Principaux articles |

| Absence de demande de consentement | 8 | 12 | Corrin et al. (2019). Madaio et al. (2021). Regan et Jesse (2019). Roberts et al. (2017). |

| 11 | 19 | Berendt et al. (2020). Corrin et al. (2019). Lawson et al. (2016). |

| 9 | 12 | Berendt et al. (2020). Regan et Jesse (2019). Smuha (2020). |

| 20 | 36 | Corrin et al. (2019). Holmes, et al. (2022). Jones et al. (2020). Southgate (2020). |

| 8 | 10 | Berendt et al. (2020). Jones et al. (2020). |

| Collecte de données sensibles ou trop nombreuses | 11 | 20 | Rubel et Jones (2016). |

| 13 | 28 | Corrin et al. (2019). Regan et Jesse (2019). |

| 17 | 23 | Southgate (2020). |

| 4 | 6 | Kitto et Knight (2019). |

| 22 | 51 | Peraya (2019). |

| 19 | 41 | Berendt et al. (2020). Lawson et al. (2016). Madaio et al. (2021). Regan et Jesse (2019). Remian (2019). |

| Systèmes non robustes ou peu fiables qui génèrent des dysfonctions | 12 | 26 | Corrin et al. (2019). Remian (2019). Smuha (2020). |

| 8 | 9 | Scholes (2016). |

| 4 | 10 | Remian (2019). Sjödén (2020, juillet). |

| 10 | 13 | Aiken et Epstein (2000). Corrin et al. (2019). Holmes et al. (2022). |

| Conséquences négatives sur l’apprentissage ou le développement | 3 | 4 | Aiken et Epstein (2000). |

| 6 | 11 | Remian (2019). Smuha (2020). |

| 15 | 19 | McStay (2020). |

| 6 | 10 | Mayfield et al. (2019, août). |

| 3 | 4 | Davies et al. (2021). McStay (2020). |

| 3 | 4 | Smuha (2020). |

| 9 | 13 | Aiken et Epstein (2000). Reiss (2021). Smuha (2020). |

Processus de conception — Un enjeu régulièrement mentionné par les auteurs et autrices consultés concerne l’exploitation possiblement nocive des données des acteurs et actrices scolaires par un SIA-ED. Cet enjeu est accru lorsque les données collectées sont sensibles ou trop nombreuses, tout particulièrement lorsqu’elles ne permettent pas de préserver l’anonymat des acteurs et actrices scolaires parce que des informations personnelles peuvent être réidentifiées par des données proxy. Plusieurs auteurs et autrices rapportent également que les données collectées peuvent servir des finalités discutables, par exemple, le contrôle et la surveillance des acteurs et actrices scolaires, ou bien qu’elles puissent être détournées de leurs usages premiers (p. ex., lorsqu’elles sont collectées sous des prétextes éducatifs et vendues à des tiers-acteurs dans des finalités commerciales). Un autre enjeu associé aux données des acteurs et actrices scolaires concerne leur conservation : quelles sont les obligations des équipes de conception à cet égard et incluent-elles un droit pour les acteurs et actrices scolaires à ne pas voir leurs données conservées? Certains auteurs et autrices soulèvent également des enjeux liés à des SIA-ED peu fiables et peu robustes, notamment la présence de données inexactes, des erreurs de classification, ou encore des failles de sécurité éventuelles. Un dernier enjeu lié à l’exploitation des données des acteurs et actrices scolaires concerne l’altération de leur consentement libre et éclairé quant à l’utilisation de leurs données par un SIA-ED. Sur le plan de la conception, cette altération peut se décliner de différentes façons : absence de demande de consentement ; impossibilité de retirer son consentement ; absence de mesures particulières pour les personnes mineures, lesquelles constituent une grande partie de la population scolaire. Par exemple, l’utilisation de données des apprenants et apprenantes pour alimenter des modèles d’apprentissage machine pose la question de la traçabilité : si une personne apprenante souhaite que ses données soient retirées, est-ce techniquement possible? Sur ce point, les données interpersonnelles — par exemple, des données vidéos mettant en scène plusieurs apprenants simultanément — posent un problème particulier : si une personne apprenante en demande la destruction, que faire pour pénaliser le moins possible les autres apprenants qui souhaitent bénéficier des avantages que le SIA-ED propose?

Processus d’usage — L’altération du consentement sur le plan de la conception peut se poursuivre lors de l’usage d’un SIA-ED sous la forme d’un consentement superficiel, c’est-à-dire, un consentement effectif qui résulte d’une impossibilité de ne pas consentir. C’est le cas lorsque les acteurs et actrices scolaires n’ont pas le choix de consentir à utiliser un SIA-ED, sans quoi ils sont pénalisés (ou pénalisent leurs enfants, pour les cas des parents d’apprenante et d’apprenante). En effet, l’utilisation de SIA-ED en salle de classe est déterminée par les acteurs et actrices scolaires. Leur autorité pédagogique conduit généralement les apprenants et apprenantes à ne pas questionner leur choix, voire à ressentir une certaine pression à utiliser un SIA-ED, ce qui devrait être pris en compte pour mettre en œuvre des mécanismes de consentement appropriés. En conséquence, l’exploitation des données par un SIA-ED peut porter atteinte à la dignité des acteurs et actrices scolaires en ayant des conséquences négatives sur leur personne. Une première conséquence négative se fait sentir lorsqu’un SIA-ED génère de l’anxiété chez les acteurs et actrices scolaires ou modifie indument leurs comportements — quitte à enfreindre leur éthique personnelle — afin de répondre positivement au fonctionnement d’un SIA-ED, particulièrement si les résultats de ces derniers sont conséquentiels, par exemple, s’ils ont une portée décisionnelle. À titre d’exemple, un acteur ou une actrice scolaire pourrait être tenté de préparer indument ses apprenants et apprenantes à la réussite d’un examen ministériel (teach to the test) afin d’augmenter leurs résultats au dit test, si ce dernier est utilisé par l’institution scolaire comme indicateur de la qualité de ses pratiques pédagogiques. Un autre enjeu rapporté par certains auteurs et autrices concerne la maximisation, l’intensification ou l’amplification de certaines modalités ou finalités pédagogiques souvent mobilisées par les SIA-ED (p. ex., ludification, apprentissage personnalisé, performance scolaire) qui sont susceptibles de générer des contre-effets pédagogiques (p. ex., apprentissage trop guidé qui entrave la libre exploration, l’imagination et la créativité) ou bien de négliger certaines finalités cruciales de l’éducation (p. ex., diminution des occasions de socialisation entre apprenants et apprenantes ou de développement de la citoyenneté).

Pour rappel, l’objectif de cette revue systématique de la littérature était d’avoir un meilleur portrait des enjeux éthiques et critiques des SIA-ED. Les résultats obtenus nous ont amenés à regrouper les 70 enjeux identifiés sous six tensions, qui deviennent effectifs lorsqu’un SIA-ED n’est pas anticipé et orienté à l’aune des conditions et des exigences éducatives. Il est important de noter que ces tensions et ces enjeux ne postulent pas une incompatibilité de nature entre, d’un côté, la technique, et de l’autre, l’éducation. C’est davantage la rencontre, toujours singulière et située, entre la technique (incluant sa conception et ses usages) et l’éducation, qui détermine quels tensions et enjeux deviennent effectifs. Notons également que si le classement des tensions et des enjeux offre une certaine intelligibilité, ces derniers restent étroitement imbriqués les uns aux autres sur deux niveaux. Au niveau analytique d’une part, les tensions et les enjeux sont difficilement dissociables. À titre d’exemple, la tension « gouvernance scolaire vs conception technique » comprend plusieurs enjeux relatifs à la gestion légale et éthique des données, ce qui s’avère complémentaire à la tension « dignité des acteurs et actrices scolaires vs exploitation des données ». Au niveau empirique d’autre part, le quotidien des différents acteurs et actrices (p. ex., équipe de conception, d’administration, personnel enseignant) est susceptible d’imbriquer étroitement les tensions et les enjeux au sein des pratiques de conception, d’implantation et d’usage des SIA-ED.

À ce titre, un prolongement scientifique immédiat de cette revue systématique de la littérature serait d’éprouver et d’affiner le système de sens proposé ici au moyen d’études empiriques, notamment des études de cas sur des SIA-ED actuellement en place dans les systèmes scolaires. Pour ce faire, ces études de cas gagneraient autant que possible à « suivre » les SIA-ED depuis leur conception jusqu’à leurs usages au moyen d’une démarche ethnographique, à l’instar des études sur l’innovation technique (p. ex., Akrich, 1987). Elles permettraient de révéler les enjeux et les combinaisons d’enjeux que les SIA-ED impliquent en situation. À titre d’exemple, ChatGPT est un SIA-ED mis sur le marché après notre recherche documentaire et qui a suscité beaucoup de discussions autour des enjeux qu’il soulève. A minima, il est susceptible de toucher aux tensions et enjeux suivants :

Ces tensions et enjeux sont toutefois potentiels et c’est bien la conception et les usages éducatifs empiriques de ChatGPT qui permettront de confirmer, d’enrichir, de préciser, d’invalider ou de nuancer les enjeux qu’il soulève singulièrement en situation. À ce titre, les tensions et enjeux de cette revue de la littérature constituent une grille de lecture générique et a priori, qui tire sa force du fait qu’elle n’est pas restreinte à un SIA-ED ou un type de SIA-ED en particulier, mais qui prend également tout son sens lorsqu’elle est appliquée à des SIA-ED concrets.

Sur le plan pratique, moyennant un effort de vulgarisation des résultats obtenus, cette revue systématique de la littérature pourrait devenir un support de formation et d’évaluation des SIA-ED par les acteurs et actrices scolaires. Plus précisément, des dispositifs tels que les ateliers délibératifs7 semblent prometteurs pour permettre aux acteurs et actrices scolaires de se sensibiliser aux enjeux éthiques et critiques SIA-ED en les évaluant de manière collective, ce qui est susceptible de leur donner une meilleure prise sur l’orientation et la gestion des SIA-ED.

Nous souhaitons remercier Nadia Naffi, professeure à l’Université Laval (Canada) et Normand Roy, professeur à l’Université de Montréal (Canada) pour leur relecture critique et constructive d’une version intermédiaire de cette revue de la littérature scientifique. Nous remercions aussi l’Observatoire international sur les impacts sociétaux de l’IA et du numérique (OBVIA) et le Groupe de recherche interuniversitaire sur l’intégration pédagogique des technologies de l’information et de la communication (GRIIPTIC) pour leur soutien financier à ce projet.

Aiken, R. M., & Epstein, R. G. (2000). Ethical guidelines for AI in education : Starting a conversation. International Journal of Artificial Intelligence in Education, 11, 163-176.

Akrich, M. (1987). Comment décrire les objets techniques? Techniques et culture, 9, 49-64.

Bruneault, F., Laflamme, A. S., & Mondoux, A. (2022). Former à l’éthique de l’IA en enseignement supérieur : référentiel de compétence. Document non publié. https://collimateur.uqam.ca/collimateur/former-a-lethique-de-lia-en-enseignement-superieur-referentiel-de-competence/

Chen, X., Xie, H., & Hwang, G. J. (2020). A multi-perspective study on artificial intelligence in education : Grants, conferences, journals, software tools, institutions, and researchers. Computers and Education. Artificial Intelligence, 1. https://doi.org/10.1016/j.caeai.2020.100005

Commission européenne. (2022). Lignes directrices éthiques sur l’utilisation de l’intelligence artificielle et des données dans l’enseignement et l’apprentissage à l’intention des éducateurs.

Corbin, J., & Strauss, A. (2008). Basics of qualitative research (3e éd.). Sage.

de Munck, J. (2011). Les trois dimensions de la sociologie critique. SociologieS. https://doi.org/10.4000/sociologies.3576

Dignum, V., Baldoni, M., Baroglio, C., Caon, M., Chatila, R., Dennis, L., Génova, G., Haim, G., Kließ, M. S., Lopez-Sanchez, M., Micalizio, R., Pavón, J., Slavkovik, M., Smakman, M., van Steenbergen, M., Tedeschi, S., van der Toree, L., Villata, S., & de Wildt, T. (2018, décembre). Ethics by design : Necessity or curse? Dans Proceedings of the 2018 AAAI/ACM Conference on AI, Ethics, and Society (p. 60-66). https://doi.org/10.1145/3278721.3278745

Dilhac, M.-A., Abrassart, C., & Voarino, N. (2018, dir.). Rapport de la Déclaration de Montréal pour un développement responsable de l’intelligence artificielle. Document non publié. https://docs.wixstatic.com/ugd/ebc3a3_d806f109c4104c91a2e719a7bef77ce6.pdf

Doroudi, S. (2022). The intertwined histories of artificial intelligence and education. International Journal of Artificial Intelligence in Education, 33, 1-44. https://doi.org/10.1007/s40593-022-00313-2

Institute for Ethical AI in Education. (2020). Ethical Framework for AI in Education.

Granjon, F. (2015). Du matérialisme comme principium d’un agenda de la recherche critique en communication. Questions de communication, 2, 157-190. https://doi.org/10.4000/questionsdecommunication.10096

Hao, K. (2020, août). The UK exam debacle reminds us that algorithms can’t fix broken system. MIT Technology Review. https://www.technologyreview.com/2020/08/20/1007502/uk-exam-algorithm-cant-fix-broken-system/

Iphofen, R., & Kritikos, M. (2021). Regulating artificial intelligence and robotics : Ethics by design in a digital society. Contemporary Social Science, 16(2), 170 184. https://doi.org/10.1080/21582041.2018.1563803

Krutka, D. G., Smits, R. M., & Willhelm, T. A. (2021). Don’t be evil : Should we use Google in schools? TechTrends, 65(4), 421-431. https://doi.org/10.1007/s11528-021-00599-4

Landry, R., Becheikh, N., Amara, N., Ziam, S., Idrissi, O., & Castonguay, Y. (2009). La recherche, comment s’y retrouver? Revue systématique des écrits sur le transfert de connaissances en éducation. Gouvernement du Québec. http://eduq.info/xmlui/handle/11515/31693

Law, J. (dir.). (1991). A sociology of monsters : Essays on power, technology, and domination. Routledge.

Le Bossé, Y. (2003). De l’« habilitation » au « pouvoir d’agir » : vers une appréhension plus circonscrite de la notion d’ empowerment. Nouvelles pratiques sociales, 16(2), 30 51. https://doi.org/10.7202/009841ar

Li, S., Yan, M., Zhang, X., & Li, Z. (2020, novembre). Analysis on the application of AI technology in online education under the public epidemic crisis. Dans International Conference on Innovative Technologies and Learning (p. 296-305). Springer.

MacKenzie, D., & Wajcman, J. (1999). The social shaping of technology. Open University Press. http://eprints.lse.ac.uk/id/eprint/28638

Marchildon, A. ( 2017). Le pouvoir de déployer la compétence éthique. Éthique publique, 19(1). https://doi.org/10.4000/ethiquepublique.2920

Marx, K. (1867/2020). Le capital. CreateSpace Independent Publishing Plateform.

Métais, F. (2018). Du contact éthique à l’heure des dispositifs « autonomes ». Revue francaise d’éthique appliquee, 5(1), 54-66. https://doi.org/10.3917/rfeap.005.0054

Oudshoorn, N., Rommes, E., & Stienstra, M. (2004). Configuring the user as everybody : Gender and design cultures in information and communication technologies. Science, Technology et Human Values, 29(1), 30-63. https://doi.org/10.1177/0162243903259190

Oudshoorn, N., Neven, L., & Stienstra, M. (2016). How diversity gets lost : Age and gender in design practices of information and communication technologies. Journal of Women & Aging, 28(2), 170-185. https://doi.org/10.1080/08952841.2015.1013834

Renz, A., & Hilbig, R. (2020). Prerequisites for artificial intelligence in further education : Identification of drivers, barriers, and business models of educational technology companies. International Journal of Educational Technology in Higher Education, 17(1), 1-21. https://doi.org/10.1186/s41239-020-00193-3

Rienties, B., Køhler Simonsen, H., & Herodotou, C. (2020, juillet). Defining the boundaries between artificial intelligence in education, computer-supported collaborative learning, educational data mining, and learning analytics : A need for coherence. Dans Frontiers in Education (vol. 5, p. 128). Frontiers Media SA. https://doi.org/10.3389/feduc.2020.00128

Roqueplo, P. (1983). Penser la technique. Pour une démocratie concrète. Seuil.

Self, J. (2016). The birth of IJAIED. International Journal of Artificial Intelligence in Education, 26(1), 4 12. https://doi.org/10.1007/s40593-015-0040-5

Selwyn, N. (2010). Looking beyond learning : Notes towards the critical study of educational technology. Journal of Computer Assisted Learning, 26(1), 65-73. https://doi.org/10.1111/j.1365-2729.2009.00338.x

UNESCO. (2019). Consensus de Beijing sur l’intelligence artificielle et l’éducation.

Verdegem, P. (2021). Introduction : Why we need critical perspectives on AI. Dans P. Verdegem (dir.), AI for Everyone? Critical Perspectives (p. 1-18). University of Westminster Press. https://doi.org/10.16997/book55.a

Williamson, B., & Eynon, R. (dir.) (2020). Editorial: historical threads, missing links, and future directions in AI in education. Learning, Media and Technology, 45(3). https://doi.org/10.1080/17439884.2020.1798995

Zawacki-Richter, O., Marín, V. I., Bond, M., & Gouverneur, F. (2019). Systematic review of research on artificial intelligence applications in higher education—where are the educators? International Journal of Educational Technology in Higher Education, 16(1), 1-27. https://doi.org/10.1186/s41239-019-0171-0

Zhang, K., & Aslan, A. B. (2021). AI technologies for education : Recent research & future directions. Computers and Education. Artificial Intelligence, 2. https://doi.org/10.1016/j.caeai.2021.100025

Simon Collin est professeur à la Faculté des sciences de l’éducation de l’Université du Québec à Montréal (UQÀM). Il est titulaire de la Chaire de recherche du Canada sur l’équité numérique en éducation (https://www.simoncollin.org/) et chercheur au Centre de recherche interuniversitaire sur la formation et la profession enseignante (CRIFPE). Il s’intéresse aux enjeux d’équité et de démocratisation que suscitent les technologies en éducation, qu’il aborde au croisement des travaux interdisciplinaires de la technique et des théories critiques. Courriel : collin.simon@uqam.ca

Alexandre Lepage est étudiant au doctorat à l’Université de Montréal depuis 2020 et chargé de cours en technologie éducative à l’Université Laval. Sa thèse porte sur l’adoption de l’intelligence artificielle par les enseignants et enseignantes du postsecondaire ainsi que sur leur niveau de littératie par rapport à son fonctionnement. Courriel : alexandre.lepage.2@umontreal.ca

Léo Nebel est doctorant en dispositif CIFRE au sein de l’équipe MOCAH du laboratoire du LIP6 de Sorbonne Université et de l’entreprise Edtech EvidenceB. Il travaille actuellement sur l’analyse automatique de productions textuelles d’étudiants et la proposition de rétroactions adaptées. Ces premiers travaux de recherche se concentrent notamment sur le processus de révision du texte. Courriel : leo-n@evidenceB.com