Tang Ba Hoang, Université de Hanoi, Vietnam

Nguyen Tan Dai, Université de Strasbourg, LISEC (UR 2310), France

Nguyen Huu Binh, Université de Langues Étrangères, Université de Danang, Vietnam

Ngo Ba Hung, Université de Can Tho, Vietnam

Vo Viet Minh Nhat, Université de Hué, Vietnam

Nguyen Thi Anh Dao, Université Nguyen Tat Thanh, Vietnam

Dinh Thi Hai, Université de Hanoi, Vietnam

Vu Tien Dat, Université de Hanoi, Vietnam

Le Vietnam est considéré comme étant avancé dans l’adoption et l’usage des technologies de l’information et de la communication (TIC) en éducation, suivant les critères définis par l’UNESCO. Cependant, la plupart des établissements d’enseignement supérieur vietnamiens ne se limitent qu’à investir dans du matériel et des équipements technologiques pour encourager les initiatives individuelles d’enseignement en ligne chez les enseignants universitaires, sans disposer de véritable politique institutionnelle de formation en ligne ni de toutes les dimensions nécessaires à l’intégration systématique des TIC. Cela les empêche d’atteindre un niveau d’efficacité suffisant et une cohérence d’ensemble. Cet article vise à présenter les résultats de l’étude des modèles de développement du cyberapprentissage dans les établissements d’enseignement supérieur du monde entier, en particulier celui de l’Association européenne des universités d’enseignement à distance (EADTU), en vue de construire un modèle d’évaluation comparative de la politique institutionnelle de l’apprentissage en ligne en fonction de la perception des étudiants. Ce modèle a fait l’objet d’une enquête auprès de 460 étudiants de quatre établissements d’enseignement supérieur vietnamiens, dont les résultats d’analyse factorielle permettent de valider une version adaptée de l’enquête au contexte local.

Mots-clés : Association européenne des universités d’enseignement à distance, enseignement supérieur, évaluation comparative, formation en ligne, perception des étudiants, Vietnam

Vietnam is ranked at the advanced stages in the adoption and use of information and communication technologies (ICTs) in education, according to the criteria defined by UNESCO. However, most Vietnamese higher education institutions are limited to investing in technological equipment and materials to encourage individual initiatives in online teaching among lecturers, without having a comprehensive institutional policy for online training, including all the dimensions necessary for the systemic integration of ICTs. This prevents them from achieving a sufficient level of efficiency and overall coherence. This article is a study of models for the overall development of e-learning in higher education institutions, in particular that of the European Association of Distance Teaching Universities (EADTU), for building a benchmarking model for e-learning institutional policy under students’ perception. This model was subject to a survey involving 460 students from four Vietnamese higher education institutions, with the result of factor analysis validating an adapted version that fits to the local context.

Keywords: benchmarking, European Association of Distance Teaching Universities, higher education, online training, students’ perception, Vietnam

Depuis la fin du xxe siècle, l’éducation a connu des changements majeurs à l’échelle mondiale grâce au développement des technologies de l’information et de la communication (TIC), en particulier l’Internet et le Web, qui permettent l’utilisation de plateformes intégrant les outils de travail individuel et renforcent le travail interactif et collaboratif en ligne. Cela permet de développer différentes méthodes pédagogiques constructivistes à plusieurs échelles (Moore & Kearsley, 2012). Au Vietnam, afin de maintenir et de renforcer les résultats initiaux encourageants obtenus depuis la période de rénovation amorcée en 1986, l’État a adopté des politiques fortes pour améliorer la qualité de l’éducation dès la première décennie du xxie siècle, dont le développement de l’utilisation des TIC dans l’enseignement et l’apprentissage figurait parmi les solutions prioritaires. Grâce à ces initiatives, le Vietnam a non seulement enregistré l’une des croissances les plus rapides au monde en matière d’infrastructures TIC pendant plusieurs années consécutives (Ca & Huong, 2009) mais il figure en bonne position relativement à l’intégration des TIC dans l’éducation (SEAMEO, 2010) selon les critères de l’UNESCO (Anderson, 2010).

Ces acquis ont permis au ministère de l’Éducation et de la Formation (MEF) vietnamien de promulguer assez tôt certains textes réglementaires régulant la mise en œuvre de la formation en ligne (FEL), en particulier la Circulaire n° 12/2016/TT-BGDDT du 22 avril 2016 définissant l’application des technologies de l’information dans la gestion et l’organisation de la formation en ligne (Circulaire 12/2016), et la Circulaire n° 10/2017/TT-BGDDT du 28 avril 2017 établissant le règlement de la formation à distance de niveau universitaire (Circulaire 10/2017). Bien que ces réglementations demeurent lacunaires, elles ont posé des bases nécessaires pour permettre à l’ensemble du système éducatif vietnamien de faire face efficacement à la pandémie de COVID-19 durant les années 2020-2021. Cependant, en ce qui a trait à la perception de l’efficacité des mesures d’enseignement à distance (EAD) au cours de cette période, majoritairement mises en œuvre via des outils de vidéoconférence, ont été détectées des divergences considérables entre différents acteurs concernés, notamment enseignants et étudiants : les enseignants ont tendance à surévaluer leur performance, et à sous-estimer leurs propres faiblesses par rapport à la perception réelle des étudiants (Ðại & Trang, 2022).

Durant cette période, le MEF a continué de publier de nouveaux textes officiels afin d’améliorer progressivement le cadre juridique de la FEL, en particulier la Circulaire n° 39/2020/TT-BGDÐT du 9 octobre 2020 définissant le standard d’évaluation de la qualité des programmes de formation à distance de niveau universitaire (Circulaire 39/2020). Cependant, dans l’ensemble, ces nouvelles réglementations relatives aux activités d’EEL en réponse à la pandémie COVID-19 n’ont pas eu d’influence significative, car elles ne proposaient pas de solutions fondamentales pour surmonter les problèmes techniques rencontrés lors des cours en ligne ouverts à tous (Phan Thị Ngọc Thanh et al., 2020), ni pour créer des espaces d’apprentissage privés et réduire les nuisances sonores (Oanh & Thuý, 2020). Bien que l’enseignement en ligne par vidéoconférence ait largement été utilisé comme modalité principale, l’utilité (usefulness) et l’utilisabilité (ease of use) de l’outil n’ont pas eu d’influence sur le comportement relativement à l’utilisation ou à l’usage réel chez les étudiants (Pho et al., 2020).

Dans ce contexte, nous avons proposé un projet de recherche scientifique et technologique de niveau ministériel intitulé « Formation en ligne de niveau universitaire dans les établissements d’enseignement supérieur vietnamiens : état des lieux et solutions », qui a été déployé de 2022 à 2024. Pendant la mise en place du projet, le MEF a successivement promulgué d’autres textes réglementaires, dont la Circulaire n° 28/2023/TT-BGDDT du 28 décembre 2023 définissant le règlement de la formation à distance de niveau universitaire (Circulaire 28/2023), qui remplace la Circulaire 10/2017, et la Circulaire n° 30/2023/TT-BGDDT du 29 décembre 2023 définissant l’application des technologiques de l’information dans la formation en ligne de niveau universitaire (Circulaire 30/2023), qui se substitue à la Circulaire 12/2016. Cependant, il faudra du temps avant de pouvoir évaluer les effets de ces mesures sur les problèmes existants.

La principale raison réside probablement dans le fait que les établissements d’enseignement supérieur (EES) vietnamiens ne disposent pas encore de véritable stratégie de développement de l’apprentissage en ligne, qui prendrait en compte toutes les dimensions indispensables à l’intégration des TIC dans l’organisation institutionnelle. La plupart se limitent à l’investissement dans les infrastructures et équipements pour encourager les initiatives individuelles, ce qui conduit à un manque de cohérence globale et réduit le niveau d’efficacité des initiatives lancées (Nguyen Tan, 2017).

En résumé, toutes ces lacunes ont montré qu’il est nécessaire d’avoir un outil de diagnostic complet qui permet aux EES vietnamiens de prendre en considération toutes les dimensions indispensables à la mise en place de leur stratégie de développement de la FEL. Ainsi, une question de recherche s’est posée : existe-t-il un ou des modèles de diagnostic de la stratégie de FEL dans le monde, notamment dans les pays développés, susceptibles d’être intégrés ou adaptés dans le contexte vietnamien? Cette question de recherche nous a conduits à étudier les approches d’évaluation de la qualité de l’enseignement supérieur en général et de la FEL en particulier, dans l’optique de concevoir un modèle d’évaluation comparative de la qualité de la FEL adapté au contexte vietnamien. Cet article présente les résultats de notre projet, avec un modèle testé auprès des étudiants de quatre EES participant au projet.

À travers le monde, l’amélioration de la qualité passe naturellement par le partage d’expériences entre les EES, et ce depuis l’origine même de l’institution universitaire. C’est sur cette base qu’est née l’approche d’évaluation comparative (benchmarking) dans l’enseignement supérieur. Celle-ci vise à comparer les méthodes et les pratiques, en particulier les bonnes, voire meilleures pratiques, dans l’organisation, la gestion et le fonctionnement des EES, tout en en permettant de diagnostiquer les problèmes existants ainsi que leurs propres points forts et faibles (Schofield, 1998). Cette approche permet aux EES non seulement de se situer vis-à-vis des standards établis ou de simplement collecter et traiter des données quantitatives, mais aussi de s’inspirer des expériences réussies ailleurs à travers les scénarios réellement mis en place avec succès (Achim et al., 2009).

Dans le domaine des TIC appliquées à l’éducation, il existe de nombreuses approches et formes de standards ou normes de qualité différentes, allant de la gestion de la qualité basée sur les processus, sur les produits ou sur les compétences, aux normes relatives au contenu, à la technologie et aux méthodes pédagogiques, etc. (Ehlers & Pawlowski, 2006). L’essentiel est que la démarche qualité dans chaque institution respecte trois étapes fondamentales :

Parmi les approches diversifiées dans la gestion de la qualité basées sur les processus, nombreuses portent sur l’étude de cas ou sur l’élaboration de concepts théoriques, de modèles, de facteurs d’évaluation, de standards et d’indicateurs, qui constituent des cadres de référence pour l’évaluation comparative de l’intégration des TIC dans l’enseignement supérieur, communément appelée « cyberapprentissage » (Huynh-Cam et al., 2021).

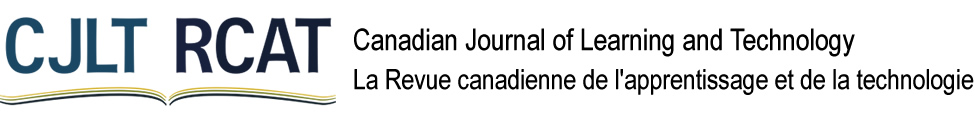

Bien que ce terme de « cyberapprentissage » donne aujourd’hui matière à différentes interprétations, il est souvent utilisé comme synonyme d’« enseignement et apprentissage en ligne » (J. L. Moore et al., 2011). Cette interprétation se rapproche de la définition proposée par l’auteur présumé du concept en 1998, Jay Cross (2004) : le cyberapprentissage est l’apprentissage à l’ère d’Internet, un point de convergence entre l’apprentissage et le réseau. Ce terme est aussi considéré comme le plus répandu parmi ceux associés à la modalité de l’« enseignement à distance » (Luppicini, 2005). Et parmi de nombreuses initiatives visant à évaluer le cyberapprentissage, ce sont celles qui émanent des projets européens dans les années 2000 et 2010 qui se démarquent, dont celui intitulé « E-xcellence+ » coordonné par l’Association européenne des universités à distance (EADTU). Il s’agit d’un modèle conceptuel d’évaluation de la qualité du cyberapprentissage dans une perspective complexe et globale, centré sur l’étudiant et structuré autour de trois dimensions principales : services, gestion et produits, comprenant sept groupes de critères : personnalisation, flexibilité, accessibilité, transparence, interaction, participation et productivité, résumés dans la figure 1 (Ossiannilsson & Landgren, 2012).

Figure 1

Modèle conceptuel de la qualité du cyberapprentissage dans une perspective complexe et globale

Source : Ossiannilsson et Landgren (2012).

Il existe depuis 2012 une version 2 de ce modèle appelé « E-xcellence » de l’EADTU, qui intègre les progrès technologiques dans la mise à jour de son standard d’évaluation comparative, notamment avec l’introduction des ressources éducatives libres (Open Educational Resources – OER). La version 3, quant à elle, intègre les cours en ligne ouverts à tous (Massive Open Online Courses – MOOC) (Kear et al., 2016). Actuellement, le cadre de référence « E-xcellence » comporte un outil de diagnostic rapide « Quick Scan » qui comprend 35 critères d’évaluation comparative dans six domaines : gestion stratégique (strategic management); conception de curriculum (curriculum design); conception de cours (course design); enseignement (course delivery); soutien aux personnels (staff support); et soutien aux étudiants (student support). Chaque établissement peut sélectionner les critères appropriés en fonction des publics cibles et des objectifs spécifiques de chaque évaluation.

En ce qui concerne les publics cibles, il s’agit en général d’une faiblesse des initiatives d’évaluation de la qualité dans l’enseignement supérieur, car on constate souvent que certains acteurs clés parmi les détenteurs d’enjeux à des étapes où ils sont pourtant directement concernés n’y participent pas (Datta, 2006). Pour un établissement ou programme universitaire, chaque détenteur d’enjeux a des attentes spécifiques vis-à-vis des résultats de l’évaluation de la qualité; dans le cas des étudiants, il s’agit des retours d’expérience des promotions précédentes (souvent rares ou peu accessibles, malheureusement) ou de leur propre satisfaction à l’égard de l’expérience d’apprentissage vécue (Hurteau, 2008; Weiss, 1983). La prise en compte de l’évaluation de l’enseignement par les étudiants (EEE) est une nécessité dans la démarche qualité de l’enseignement supérieur, comme l’ont montré de nombreuses recherches au fil des décennies, et elle sera d’autant plus facilitée par l’utilisation accrue des outils informatiques et d’Internet (Younès & Romainville, 2012).

À ce jour, la plupart des outils d’enquête qui permettent d’obtenir l’avis des étudiants se concentrent sur l’évaluation de l’enseignement, soit des programmes ou des cours. L’un des premiers modèles reconnus est le questionnaire « Students’ Evaluation of Educational Quality » (SEEQ), utilisé à l’Université de Californie, à Los Angeles (UCLA) à la fin des années 1970 et au début des années 1980 (Marsh, 1982). Le « Course Experience Questionnaire » (CEQ), développé en Australie à la fin des années 1980 pour évaluer la qualité des formations universitaires du point de vue des diplômés, est un autre exemple (Ramsden, 1991). En s’inspirant du CEQ, Entwistle et ses collaborateurs (2002) ont élaboré le « Experiences of Teaching-Learning Questionnaire » (ETLQ) au Royaume-Uni, dans le cadre d’une collaboration entre les universités d’Édimbourg, de Durham et de Coventry, avec pour cible les étudiants en cours d’études. Au Canada, l’Université du Québec à Rimouski a également adapté le SEEQ à son propre contexte entre 2007 et 2011 (Harvey & Hébert, 2012).

Si les modèles SEEQ, CEQ et ETLQ se concentrent principalement sur les interactions entre les enseignants et les étudiants à l’échelle des cours, Ginns et ses collaborateurs (2007) à l’Université de Sydney ont adapté le CEQ en « Student Course Experience Questionnaire » (SCEQ) pour mesurer la qualité de l’ensemble des programmes universitaires, selon le point de vue des étudiants inscrits. Ils ont aussi fait évoluer le modèle en créant le « e-Learning Experience Questionnaire » (eLEQ), pour évaluer l’apport des technologies de l’information et de la communication dans la formation universitaire, notamment dans la modalité de formation hybride (blended learning) venant en appui des activités pédagogiques en présentiel (Ginns & Ellis, 2007). Plus précisément, l’eLEQ comporte 18 questions couvrant quatre dimensions de l’intégration des TIC dans la formation universitaire :

Parallèlement, d’autres modèles étudiés portent sur le comportement des utilisateurs vis-à-vis des systèmes et outils technologiques mobilisés dans l’éducation et sur leur adoption de ceux-ci. L’un des plus notables est le « Technology Acceptance Model » (TAM), proposé par Fred D. Davis (1989), que Venkatesh et ses collègues (2003) ont ensuite adapté en « Unified Theory of Acceptance and Use of Technology » (UTAUT). Concernant l’usage des technologies en classe, le modèle TPCK de Mishra et Koehler (2006), renommé ensuite TPACK (Thompson & Mishra, 2007), met en évidence les liens complexes entre technologie (T), pédagogie (P), contenu (C) et connaissances (K).

Il existe sans doute d’autres modèles que nous ne pouvons pas tous citer, qu’il s’agisse de l’apprentissage en ligne ou de l’EEE. Les quelques exemples explicités permettent en revanche de mettre en évidence l’existence d’une variété de modèles susceptibles de répondre au besoin des EES au Vietnam, qui sont dépourvus actuellement d’un outil de diagnostic et de développement global du cyberapprentissage. Parmi différents modèles susmentionnés, celui d’« E-xcellence » de l’EADTU apparaît comme le plus adapté car il couvre plusieurs dimensions qui ne sont pas toutes abordées dans d’autres modèles. Cependant, il est nécessaire de mener des études de cas pour déterminer progressivement l’adéquation des outils d’évaluation comparative d’EADTU à l’environnement spécifique de l’enseignement supérieur vietnamien. En outre, comme plusieurs détenteurs d’enjeux sont impliqués dans les processus variés d’un dispositif de FEL, ces études devraient porter sur des publics cibles particuliers, en priorité sur les étudiants, avec des ajustements adaptés à leurs caractéristiques spécifiques.

Pour mener cette étude, nous avons réalisé les étapes suivantes :

À l’étape 1, parmi les 35 critères répartis dans six dimensions de l’outil de diagnostic rapide de l’EADTU (version 3), nous avons identifié sept critères de quatre dimensions qui devaient être subdivisés. À l’étape 2, nous avons obtenu un total de 42 critères distincts, dont 26 critères répartis dans cinq dimensions ont été retenus pour le questionnaire final auprès des étudiants. Les résultats de la subdivision et de la sélection des critères sont résumés dans le tableau 1.

Tableau 1

Résultats de la subdivision et de la sélection des critères d’évaluation comparative de l’EADTU destinés aux étudiants

| Dimension | Notation conventionnelle | Nombre de critères initiaux | Nombre de critères à subdiviser | Nombre de critères après la subdivision | Nombre de critères sélectionnés pour l’enquête |

| 1. Gestion stratégique | STR | 5 | 2 | 7 | 3 |

| 2. Conception de curriculum | CUR | 4 | 0 | 4 | 4 |

| 3. Conception de cours | CRS | 9 | 2 | 11 | 8 |

| 4. Enseignement | DLV | 6 | 2 | 8 | 5 |

| 5. Soutien aux personnels | STF | 6 | 0 | 6 | 0 |

| 6. Soutien aux étudiants | STD | 5 | 1 | 6 | 6 |

| Total | 35 | 7 | 42 | 26 |

Note : STR = strategy ; CUR = curriculum ; CRS = courses ; DLV = delivery ; STF = staff ; STD = students.

Le questionnaire d’enquête en ligne avec la structure des questions est joint en annexe 1 et accessible en entier à l’adresse bit.ly/eadtu-vn_std. Les questions du modèle EADTU utilisent une échelle de Likert à cinq niveaux : 1) Complètement en désaccord; 2) Désaccord; 3) Neutre; 4) D’accord; 5) Complètement d’accord. L’enquête a été soumise aux étudiants de troisième et quatrième années (ayant expérimenté les deux modalités de cours en présentiel et en ligne, notamment durant la période de la pandémie de COVID-19), issus de quatre EES participant au projet : Université de Hué, Université des langues étrangères – Université de Danang, Université Nguyen Tat Thanh et Université de Can Tho. Les invitations à participer à l’enquête ont été envoyées aux étudiants via les systèmes de messagerie de chaque EES concerné. L’enquête s’est déroulée d’octobre 2023 à janvier 2024.

Les données brutes ont été extraites de Google Forms et converties en format Microsoft Excel pour le tri et le traitement préliminaire avant leur importation dans le logiciel SPSS (version 22.0) pour les analyses quantitatives. Le processus d’analyse des données quantitatives comprend quatre étapes :

Après trois mois d’enquête, nous avons obtenu un total de 460 réponses valides, avec une répartition de 66,7 % d’étudiants en troisième année et 33,3 % en quatrième année. Le taux des filles s’élève à 74 %, tandis que celui des garçons est de 25 %; 1 % ayant préféré ne pas préciser leur genre. La grande majorité des répondants suit des programmes de formation initiale (99 %), tandis que seulement 1 % sont inscrits aux programmes de formation continue. La répartition des répondants par domaines scientifiques est présentée dans le tableau 2.

Tableau 2

Répartition des répondants à l’enquête par domaines scientifiques.

| Domaine scientifique | Quantité | Pourcentage |

| Sciences de l’éducation et formations des enseignants | 22 | 4,8 % |

| Sciences humaines, sociales, langues étrangères et services | 228 | 49,6 % |

| Économie, gestion et droit | 49 | 10,0 % |

| Sciences naturelles, techniques et ingénieries | 8 | 1,7 % |

| Mathématiques et statistiques | 16 | 3,5 % |

| Informatique et technologies de l’information | 31 | 6,7 % |

| Sciences de la santé | 106 | 23,0 % |

| Total | 460 | 100 % |

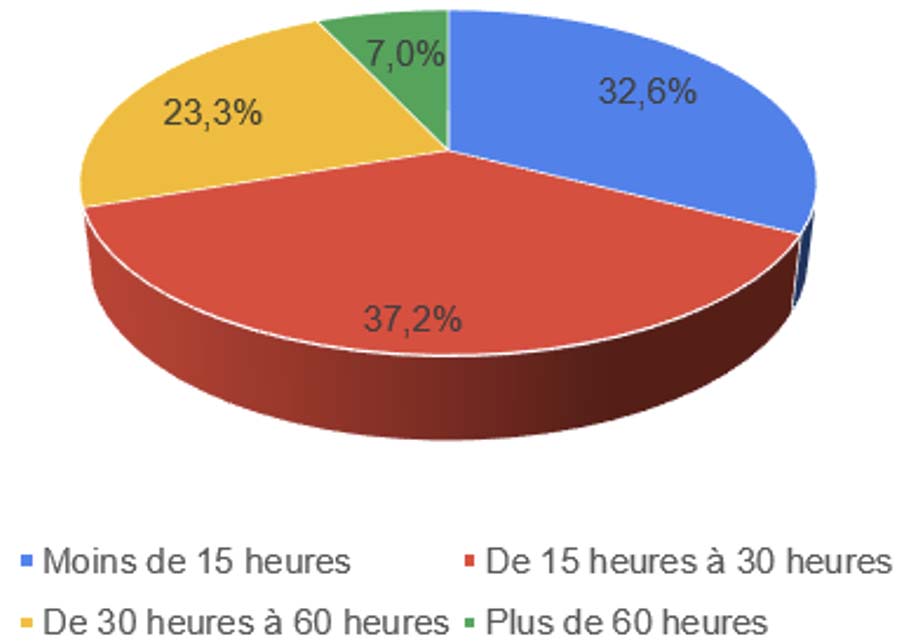

En ce qui concerne l’expérience vécue de FEL à l’université (Figure 2), la répartition est relativement équilibrée entre les trois groupes : moins de 15 heures (32,6 %), de 15 à 30 heures (37,2 %) et plus de 30 heures (29,3 %).

Figure 2

Pourcentage de la population étudiée ayant fait l’expérience de la formation en ligne

Les données de l’enquête portant sur ces 460 étudiants de troisième et de quatrième années ont été utilisées pour analyser la fiabilité alpha, en référence aux cinq dimensions initiales codées respectivement comme suit : 1) Gestion stratégique [STR]; 2) Conception de curriculum [CUR]; 3) Conception de cours [CRS]; 4) Enseignement [DLV]; 5) Soutien aux étudiants [STD]. Pour chaque dimension, les items d’enquête sont numérotés de 1 à 3, 4, 5, 6 ou 8, selon le nombre de questions sélectionnées. Les résultats du test de fiabilité sont présentés dans le tableau 3. En général, la structure du questionnaire, composé de cinq dimensions et 26 critères pour les étudiants, s’est avérée d’une grande cohérence avec une fiabilité interne élevée, dont les valeurs alpha allant de 0,887 à 0,966 sont conformes aux attentes d’une analyse factorielle.

Tableau 3

Résultats de la fiabilité des dimensions

| Dimension | Critère d’enquête | Valeur moyenne | Écart-type | Valeur alpha de Cronbach | Nombre d’items |

| 1. Gestion stratégique (STR) | STR1 | 3,93 | ,911 | ,887 | 3 |

| STR2 | 3,93 | ,886 | |||

| STR3 | 3,85 | ,902 | |||

| 2. Conception de curriculum (CUR) | CUR1 | 3,84 | ,940 | ,944 | 4 |

| CUR2 | 3,93 | ,864 | |||

| CUR3 | 3,88 | ,864 | |||

| CUR4 | 3,88 | , 873 | |||

| 3. Conception de cours (CRS) | CRS1 | 3,96 | ,872 | ,966 | 8 |

| CRS2 | 3,92 | ,889 | |||

| CRS3 | 3,81 | ,881 | |||

| CRS4 | 3,88 | ,862 | |||

| CRS4 | 3,88 | ,862 | |||

| CRS5 | 3,93 | ,856 | |||

| CRS7 | 3,93 | ,861 | |||

| CRS8 | 3,87 | ,912 | |||

| 4. Enseignement (DLV) | DLV1 | 3,85 | ,882 | ,949 | 5 |

| DLV2 | 3,87 | ,881 | |||

| DLV3 | 3,88 | ,889 | |||

| DLV4 | 3,89 | ,904 | |||

| DLV5 | 3,83 | ,882 | |||

| 5. Soutien aux étudiants (STD) | STD1 | 3,95 | ,931 | ,952 | 6 |

| STD2 | 3,94 | ,895 | |||

| STD3 | 3,93 | ,854 | |||

| STD4 | 3,88 | ,892 | |||

| STD5 | 3,93 | ,864 | |||

| STD6 | 3,97 | ,858 |

Les données recueillies ont ensuite été utilisées pour une analyse factorielle exploratoire. Après plusieurs essais, nous avons constaté une certaine inconsistance dans les résultats d’analyse, ce qui nous a conduits à éliminer progressivement quelques items susceptibles de générer des perturbations, en particulier les quatre suivants : STR3, DLV5, STD2, et STD6. L’analyse des 22 items restants a permis de valider la répartition de la majorité des items dans leurs dimensions correspondantes (Tableau 4). Cependant, deux items, l’un de la dimension « Conception de cours » (CRS8) et l’autre de « Soutien aux étudiants » (STD1), ont été transférés dans la dimension « Enseignement » (DLV).

Tableau 4

Résultats de l’analyse factorielle exploratoire

| Dimension | Item | Composante | ||||

| 1 | 2 | 3 | 4 | 5 | ||

| Enseignement (DLV) | DLV2 | ,717 | ||||

| DLV3 | ,656 | |||||

| DLV4 | ,617 | |||||

| DLV1 | ,613 | |||||

| STD1 | ,603 | |||||

| CRS8 | ,592 | |||||

| Conception de cours (CRS) | CRS2 | ,672 | ||||

| CRS4 | ,651 | |||||

| CRS5 | ,620 | |||||

| CRS7 | ,608 | |||||

| CRS1 | ,594 | |||||

| CRS6 | ,564 | |||||

| CRS3 | ,515 | |||||

| Conception de curriculum (CUR) | CUR1 | ,682 | ||||

| CUR4 | ,664 | |||||

| CUR3 | ,630 | |||||

| CUR2 | ,604 | |||||

| Soutien aux étudiants (STD) | STD3 | ,703 | ||||

| STD4 | ,681 | |||||

| STD5 | ,665 | |||||

| Gestion stratégique (STR) | STR1 | ,716 | ||||

| STR2 | ,649 | |||||

Méthode d’extraction : analyse des composantes principales. Méthode de rotation : Varimax avec application de la normalisation de Kaisea.

a La rotation a été obtenue en 10 itérations.

Les résultats d’analyse factorielle exploratoire sont utilisés à l’étape suivante conformément aux paramètres et indices présentés dans la rubrique « Méthode de recherche ». Les résultats obtenus sont :

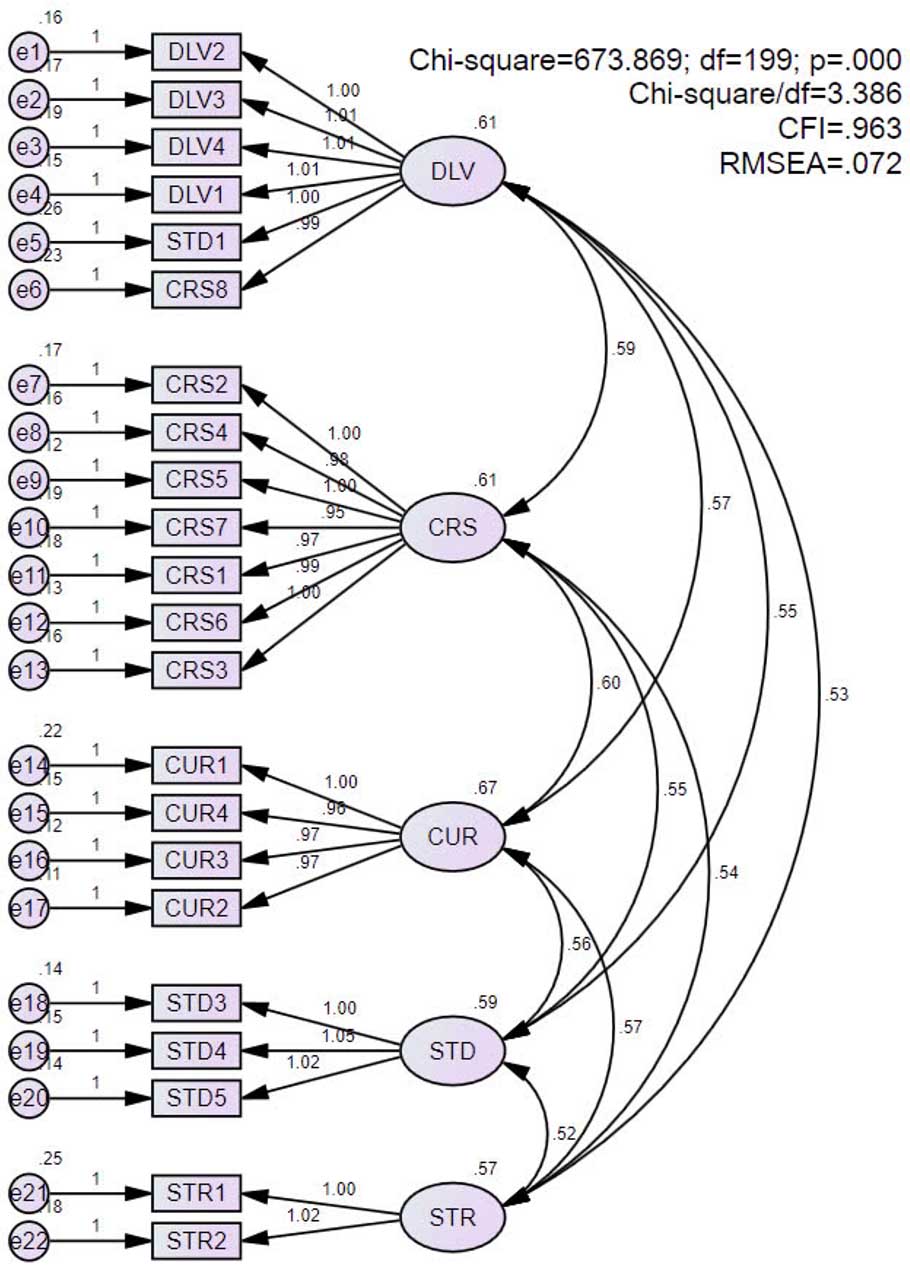

Le schéma de modélisation par équations structurelles des données d’enquête obtenues est présenté dans la figure 3.

Figure 3

Résultats d’analyse factorielle confirmatoire

Les résultats d’analyse présentés ont montré que l’échantillon choisi est tout à fait conforme aux objectifs de l’étude. Le nombre de réponses valides obtenues indique un ratio de 18:1 par rapport au nombre d’items du questionnaire, ce qui est nettement supérieur au seuil de 10:1 recommandé par Costello et Osborne (2005). En ce qui concerne la répartition des domaines scientifiques, la représentation totale des étudiants en « Sciences de l’éducation et formations des enseignants » et en « Sciences humaines, sociale, langues étrangères et services » est de 64,4 %, celle des domaines « Sciences naturelles, techniques et ingénieries », « Mathématiques et statistiques », et « Informatique et technologies de l’information » de 11,9 %, et finalement celle de « Sciences de la santé » de 23 %. Au total, le taux des filles est trois fois plus élevé que celui des garçons. Ces chiffres correspondent aux autres études dans le monde sur les orientations et les aspirations professionnelles des jeunes dans l’enseignement supérieur. En Europe, environ 65 % des étudiants inscrits dans les domaines de « Sciences sociales, journalisme et information » ou « Arts et humanités » sont féminins, voire plus de 72 % en « Médecine et santé » et plus de 79 % en « Éducation » (Eurostat, 2024). Au Vietnam, malgré l’absence des statistiques officielles actualisées, des études de la Banque mondiale sur l’enseignement supérieur vietnamien des années 2002-2005 ont également indiqué un taux d’étudiantes inscrites dans les domaines de sciences sociales et de l’éducation d’environ 70 % (Evans & Rorris, 2009). Ou plus récemment, les statistiques du MEF en 2018 montraient que le taux des filles dans les domaines de sciences, technologies, ingénieries et mathématiques (STEM) ne représentait qu’environ 34 % (World Bank, 2020).

Quant à l’expérience de la FEL, les répondants, dont approximativement les deux tiers étaient en troisième année et un tiers en quatrième année, sont répartis en trois groupes relativement équilibrés : moins de 15 heures, de 15 à 30 heures, et plus de 30 heures d’apprentissage. Les apprentissages ont pu avoir lieu principalement durant les périodes de continuité pédagogique lors de la pandémie de COVID-19 en 2020 et 2021. Après cette crise mondiale, les quatre EES vietnamiens participant au projet ont établi leurs réglementations internes pour réguler les activités de FEL dans tous les programmes de formation réguliers (communication interne), mais qui servent principalement à les encourager sans les exiger obligatoirement. Il existe peu d’études publiées sur le volume horaire des activités d’apprentissage en ligne des étudiants vietnamiens, tant durant la pandémie de COVID-19 qu’à la suite de celle-ci, mais une enquête menée auprès de 1 139 étudiants d’une université basée à Hô Chi Minh-Ville a montré qu’entre mars et mai 2020, le taux des étudiants participant à la FEL par vidéoconférence est d’environ 31 % pour 1-2 cours, 37 % pour 3-4 cours et 32 % pour plus de 5 cours (Ðại & Trang, 2022).

Cette mise en perspective permet ainsi de confirmer que les caractéristiques principales de la population étudiée, telles que la répartition des domaines scientifiques, le taux des garçons-filles, l’ancienneté et l’expérience de la FEL, répondent tout à fait aux objectifs de recherche fixés. Cela permet de justifier la pertinence des résultats d’enquête obtenus et la poursuite des analyses de ces résultats sur le plan quantitatif.

Le résultat du test de fiabilité alpha a montré que le questionnaire d’enquête sur le modèle d’EADTU soumis aux étudiants vietnamiens indique une validité interne élevée. Et pourtant, plusieurs valeurs d’alpha dépassent le seuil de 0,90, ce qui correspond aux recommandations de Tavakol et Dennick (2011) au fait de rechercher des améliorations possibles, car il existe probablement des questions répétitives, ou dont la formulation est trop longue. Ces perturbations sont constatées plus nettement pour les quatre items STR3, DLV5, STD2 et STD6 qui ont été finalement exclus du modèle.

Quant à chaque facteur analysé, la dimension « Gestion stratégique » (STR) comprend deux items retenus qui sont « Les politiques de cyberapprentissage sont conformes aux cadres juridiques et éthiques » (STR1) et « La politique de l’établissement garantit que les systèmes d’apprentissage en ligne [...] sont compatibles avec les systèmes d’information de gestion connexes [...] et qu’ils sont fiables, sûrs et efficaces » (STR2). En particulier, les aspects d’éthique et de cadre juridique font partie des composantes importantes dans les modèles de compétences numériques des apprenants aujourd’hui (Janssen et al., 2013; Janssen & Stoyanov, 2012), ce qui explique la pertinence, selon eux, d’avoir intégré l’item STR1 à la dimension stratégique. En ce qui concerne l’item STR2, une autre étude réalisée auprès de 453 étudiants de cinq programmes de formation universitaires vietnamiens en 2015 a montré que les systèmes d’information et d’assistance pédagogique institutionnels jouent un rôle complémentaire aux autres systèmes ou outils de travail individuels des étudiants et enseignants, ce qui permet de déterminer la satisfaction des étudiants dans les cours ayant recours aux TIC (Nguyen Tan, 2017).

Par ailleurs, la dimension « Conception de curriculum » (CUR) comprend quatre items qui sont tous adaptés au contexte de l’enseignement supérieur vietnamien. Il s’agit d’une différence notable entre le modèle d’EADTU et les autres modèles évoqués dans la revue de la littérature. En effet, la structure et le contenu des programmes de formation sont des critères importants dans l’évaluation de la qualité des programmes de formation universitaire au Vietnam, largement inspirés du référentiel de l’ ASEAN University Network Quality Assurance (AUN-QA) (AUN, 2020). De la même façon, le standard d’évaluation de la qualité des programmes de formation à distance, promulgué par la Circulaire 39/2020, comporte aussi une dimension (numéro 2) sur « Le descriptif, la structure, le contenu du programme de formation »1.

Une analyse plus approfondie permet de constater que la dimension « Conception de cours » (CRS) est constituée de sept critères concernant les buts et objectifs de formation (deux critères), le gabarit commun pour tous les cours (un critère), les ressources et activités pédagogiques (deux critères) et l’évaluation des apprentissages (deux critères). Tous ces critères ont été validés d’après l’enquête réalisée auprès de 460 étudiants. En comparaison avec les standards d’évaluation de la qualité des programmes de formation universitaire au Vietnam, y compris en ce qui a trait aux formations à distance, le nombre et la formulation de ces critères sont relativement clairs et concis.

En dehors du Vietnam, le standard de l’AUN-QA comprend trois dimensions avec au total 18 critères concernant les buts et objectifs de la formation, la stratégie pédagogique et l’évaluation (AUN, 2020). La raison est simple : le standard vietnamien régulé par la Circulaire 04/2016 a été conçu à partir de la version 3.0 du standard d’AUN-QA (Hung, 2024). Il existe aussi un standard des cours en ligne, Quality Matters (2018), qui comprend quatre dimensions avec au total 19 critères relatifs aux objectifs d’apprentissage, ressources et activités pédagogiques, et évaluations des apprentissages. Il est certes utile d’avoir des dispositions spécifiques finement définies pour bien réguler la qualité des cours en ligne. En revanche, par rapport au besoin d’un modèle global de développement du cyberapprentissage pour un EES, se limiter à sept critères concis dans une dimension liée à l’aspect « Conception de cours » semble être un choix pertinent, ce qui a été validé par l’enquête réelle réalisée auprès des étudiants des quatre EES vietnamiens participant au projet. Il est à noter aussi que les ressources éducatives libres, sujet d’actualité ces dernières années et intégrées dans le modèle d’EADTU à partir de la version 2 (Williams et al., 2012), possèdent leur propre critère (CRS3).

En ce qui concerne la dimension « Enseignement », quatre des cinq items initiaux ont été validés à travers l’enquête auprès des étudiants des quatre EES vietnamiens participant au projet. Parmi ces items, deux critères relatifs à la sécurité (DLV2) du système technique de FEL, et les ressources d’information et guides d’utilisation des outils (DLV4) sont également abordés dans les standards existants, comme la Circulaire 39/2020 ou Quality Matters. Cependant, deux critères, DLV1, « Les spécifications techniques du système de cyberapprentissage sont basées sur les exigences des parties prenantes et impliquent des estimations réalistes de l’utilisation et du développement du système » et, DLV3, « Les systèmes de cyberapprentissage offrent un choix d’outils en ligne adaptés aux modèles éducatifs adoptés et aux besoins des étudiants et des éducateurs », apportent une véritable nouveauté, jamais abordée dans les aux standards susmentionnés. Quant à l’item DLV5, « Les documents institutionnels et les informations accessibles par l’intermédiaire de l’ENA [environnement numérique d’apprentissage] sont régulièrement contrôlés, révisés et mis à jour », le fait qu’il est exclu du modèle d’étude pose la question de la pertinence de ce contenu dans l’enquête menée auprès des étudiants. Le résultat de notre étude indique que cet item n’est pas pertinent, mais d’autres études complémentaires seront nécessaires pour apporter davantage d’éclairage à cet effet.

De même, deux items venant d’autres dimensions ont été intégrés à notre étude : STD1, « Les étudiants reçoivent des informations claires et actualisées sur leurs cours, y compris sur les méthodes d’apprentissage et d’évaluation », et, CRS8, « Des mesures appropriées sont en place pour empêcher l’usurpation d’identité et/ou le plagiat, en particulier lorsque les évaluations sont effectuées en ligne ». Dans ce cas, il est compréhensible que, pour les étudiants, les informations sur les cours et les mesures de prévention des fraudes en ligne appartiennent à la dimension « Enseignement ». La transposition de ces deux critères ne change pas la nature du sujet abordé dans les formulations concernées. Dans le cadre limité de ce projet, nous pouvons accepter ce résultat, mais davantage d’études seront nécessaires dans le futur pour y apporter des connaissances complémentaires.

Enfin, pour la dimension « Soutien aux étudiants » (STD), outre l’item susmentionné STD1, trois autres items sont tous retenus dans le modèle d’étude : STD3 (lignes directrices spécifiques au cyberapprentissage), STD4 (création des communautés d’étudiants en ligne) et STD5 (services de soutien, technique, administratif et de conseils). Deux de ces trois critères, STD3 et STD5, sont également présents dans les standards existants, et le dernier, STD4, représente la nouveauté du modèle d’EADTU. Ce point est évidemment crucial, car l’aspect social a été reconnu comme un facteur indispensable dans les apprentissages en ligne (Tu & McIsaac, 2002), qui influençait la satisfaction, la motivation, l’assiduité et la perspective de réussite des étudiants (Richardson et al., 2017). De plus, il a été démontré qu’un dispositif d’apprentissage en ligne peut aujourd’hui tout à fait reposer sur les relations sociales dans la communauté d’apprentissage en ligne, ce qui permet de suggérer les cours plus pertinents par rapport aux besoins et aux préférences individuelles des étudiants (Senthil kumaran et al., 2014). Et à l’ère de l’explosion des applications de réseaux sociaux, la migration des interactions de la communauté d’apprentissage en ligne dans les ENA ou les Learning Management System (LMS) institutionnels vers les plateformes de médias sociaux publics, plus fonctionnels et confortables, devient une tendance inévitable (Garavaglia & Petti, 2015).

En résumé, pour l’ensemble des dimensions, le résultat de l’analyse factorielle confirmatoire et de modélisation par équations structurelles montre que le modèle d’évaluation comparative du cyberapprentissage d’EADTU vis-à-vis de la perception des étudiants est bien valide dans le contexte vietnamien, avec certaines adaptations telles que présentées dans l’annexe 2. Les paramètres et indices principaux se trouvent dans les seuils de valeurs acceptables.

L’objectif de cette étude est de construire un modèle international d’évaluation comparative du cyberapprentissage vis-à-vis de la perception des étudiants, adapté au contexte de l’enseignement supérieur vietnamien. Ce modèle constituera un outil permettant aux EES vietnamiens de développer leur stratégie d’apprentissage en ligne de manière cohérente et globale. Les résultats d’analyse des données d’enquête auprès de 460 étudiants en troisième et quatrième années de quatre EES participant au projet ont montré que le modèle d’EADTU, avec certaines adaptations présentées dans l’annexe 2, est tout à fait pertinent.

Cette validation permettra aux EES vietnamiens d’utiliser ce questionnaire d’enquête (5 facteurs, 22 items) pour mesurer le niveau de satisfaction de leurs utilisateurs principaux vis-à-vis des dispositifs de formation en ligne qu’ils mettent en place. L’analyse multidimensionnelle de ces résultats d’enquête permettra aux EES vietnamiens de consolider leur plan stratégique de développement de l’apprentissage en ligne, en ajustant les aspects qui nécessitent des améliorations en fonction des commentaires des étudiants. Ce modèle initial pourra être source d’inspiration pour développer d’autres modèles plus spécifiquement adaptés aux autres groupes de publics cibles et de détenteurs d’enjeux, en particulier les enseignants-chercheurs et le personnel des services de soutien. Sur la base de ce cadrage général, certains sous-critères spécifiques ou indicateurs pourront être raffinés dans les processus quotidiens afin de bien articuler les mesures cohérentes à différents niveaux d’action, dans l’ensemble des programmes de formation et des cours dispensés.

Cependant, notre étude comporte certaines limites telles qu’explicitées dans les discussions concernées. Premièrement, il existe dans les critères du référentiel d’EADTU de nombreuses formulations longues et complexes qui, malgré le niveau de précision des détails, risquent de réduire la qualité des questionnaires d’enquête. Cette complexité impacte considérablement la cohérence des résultats obtenus et la validité des construits. Les questions devront ainsi être réécrites pour faire en sorte qu’elles soient plus courtes et plus succinctes. Deuxièmement, l’exclusion des items STR3, DLV5, STD2 et STD6 du modèle initial ainsi que le transfert des items CRS8 et STD1 au groupe DLV mériteront des études plus approfondies pour confirmer ou infirmer notre modèle obtenu. Troisièmement, il sera souhaitable d’élargir l’éventail des étudiants bien au-delà des troisième et quatrième années, et ce dans plusieurs autres domaines de formation.

Les auteurs adressent leur remerciement sincère au ministère de l’Éducation et de la Formation vietnamien, qui a octroyé un soutien financier au projet de recherche scientifique et technologique de niveau ministériel en 2022 « Formation en ligne de niveau universitaire dans les établissements d’enseignement supérieur vietnamiens : état des lieux et solutions » (B2022-NHF-03), porté par l’Université de Hanoi. Les informations présentées dans cet article représentent uniquement le point de vue des auteurs

Achim, M. I., Căbulea, L., Popa, M., & Mihalache, S.-Ş. (2009). On the role of benchmarking in the higher education quality assessment. Annales Universitatis Apulensis Series Oeconomica, 11(2), 850-857.

Anderson, J. (2010). ICT transforming education: A regional guide. UNESCO.

AUN. (2020). Guide to AUN-QA assessment at programme level (version 4.0). ASEAN University Network.

Ca, T. N., & Huong, N. T. T. (2009). Vn Vietnam. Dans P. B. Arintoet et S. Akhtar (dir.), Digital Review of Asia Pacific 2009-2010 (p. 358-365). SAGE Publications.

Costello, A. B., & Osborne, J. (2005). Best practices in exploratory factor analysis: Four recommendations for getting the most from your analysis. Practical Assessment, Research, and Evaluation, 10(1), 7. https://doi.org/10.7275/jyj1-4868

Cross, J. (2004). An informal history of eLearning. On the Horizon, 12(3), 103-110. https://doi.org/10.1108/10748120410555340

Ðại, N. T., & Trang, N. T. T. (2022). Nghiên cứu dạy học trực tuyến bằng hội thảo truyền hình với « lý thuyết tương tạo từ xa » : Kết quả bước ðầu tại một trường ðại học Việt Nam [Studying online teaching by videoconference with the theory of transactional distance: Preliminary results from a Vietnamese university]. Tạp chí Khoa học xã hội Thành phố Hồ Chí Minh [Review of Social Sciences Ho Chi Minh City], 292(12), 47-65.

Datta, L. (2006). The practice of evaluation: Challenges and new directions. Dans I. F. Shaw, J. C. Greene et M. M. Mark (dir.), The SAGE handbook of evaluation (p. 419-438). SAGE Publications.

Davis, F. D. (1989). Perceived usefulness, perceived ease of use, and user acceptance of information technology. MIS Quarterly, 13(3), 319-340. https://doi.org/10.2307/249008

Ehlers, U.-D., & Pawlowski, J. M. (2006). Quality in European e-learning: An introduction. Dans U.-D. Ehlerset et J. M. Pawlowski (dir.), Handbook on quality and standardisation in e-learning (p. 1-13). Springer. https://doi.org/10.1007/3-540-32788-6_1

Entwistle, N., McCune, V., & Hounsell, J. (2002). Approaches to study and perceptions of university teaching-learning environments. Concepts, measures and preliminary findings (Enhancing Teaching-Learning Environments in Undergraduate Courses Project Occasional Report 1). University of Edinburgh. https://doi.org/10.13140/RG.2.2.33594.80329

Eurostat. (2024, septembre). Tertiary education statistics. Eurostat Statistics Explained. https://ec.europa.eu/eurostat/statistics-explained/index.php?title=Tertiary_education_statistics

Evans, K., & Rorris, A. (2010). Optimising the impact of Vietnam’s higher education sector on socio-economic development. Dans G. Harman, M. Hayden et Pham Thanh Nghi (dir.), Reforming higher education in Vietnam (p. 167-181). Springer. https://doi.org/10.1007/978-90-481-3694-0_12

Garavaglia, A., & Petti, L. (2015). University student communities and media habits: From formal LMS to social networks. Procedia - Social and Behavioral Sciences, 197, 898-903. https://doi.org/10.1016/j.sbspro.2015.07.270

Ginns, P., & Ellis, R. (2007). Quality in blended learning: Exploring the relationships between on-line and face-to-face teaching and learning. The Internet and Higher Education, 10(1), 53-64. https://doi.org/10.1016/j.iheduc.2006.10.003

Ginns, P., Prosser, M., & Barrie, S. (2007). Students’ perceptions of teaching quality in higher education: The perspective of currently enrolled students. Studies in Higher Education, 32(5), 603-615. https://doi.org/10.1080/03075070701573773

Harvey, L., & Hébert, M.-H. (2012). Évaluation de la qualité de l’enseignement par les étudiantes et étudiants : Qualités psychométriques et comparaison des conditions de passation. Mesure et évaluation en éducation, 35(3), 31-60. https://doi.org/10.7202/1024669ar

Hooper, D., Coughlan, J., & Mullen, M. (2008). Structural equation modelling: Guidelines for determining model fit. Electronic Journal of Business Research Methods, 6(1), 53-60. https://www.researchgate.net/publication/254742561_Structural_Equation_Modeling_Guidelines_for_Determining_Model_Fit

Hung, T. (2024, October 23). MoET revises accreditation standards to ensure quality education (Thanh Tam, Trans.). Sai Gon Giai Phong News. https://en.sggp.org.vn/share113308.html

Hurteau, M. (2008). L’implication des détenteurs d’enjeux (stakeholders) au sein de la démarche d’évaluation de programme : problème et/ou solution? Mesure et évaluation en éducation, 31(3), 63-76. https://doi.org/10.7202/1024965ar

Huynh-Cam, T.-T., Agrawal, S., Chen, L.-S., & Nguyen, Q.-A. (2021). E-Learning benchmarking in higher education: Methodology literature review. Proceedings of the 5th International Conference on Education and Multimedia Technology, 225-233. https://doi.org/10.1145/3481056.3481081

Janssen, J., & Stoyanov, S. (2012). Online consultation on experts’ views on digital competence (JRC Technical Reports EUR 25475 EN) (p. 74). Joint Research Centre, European Commission.

Janssen, J., Stoyanov, S., Ferrari, A., Punie, Y., Pannekeet, K., & Sloep, P. (2013). Experts’ views on digital competence: Commonalities and differences. Computers & Education, 68, 473-481. https://doi.org/10.1016/j.compedu.2013.06.008

Kear, K., Rosewell, J., Williams, K., Ossiannilsson, E., Rodrigo, C., Sánchez-Elvira Paniagua, Á., Santamaría Lancho, M., Vyt, A., & Mellar, H. (2016). Quality assessment for e-learning. A benchmarking approach (3e ed.). European Association of Distance Teaching Universities (EADTU). https://e-xcellencelabel.eadtu.eu/e-xcellence-review/manual

Kline, K. (2016). Jean Baudrillard and the limits of critical media literacy. Educational Theory, 66(5), 641-656. https://doi.org/10.1111/edth.12203

Luppicini, R. (2005). A systems definition of educational technology in society. Journal of Educational Technology & Society, 8(3), 103-109. http://www.jstor.org/stable/jeductechsoci.8.3.103

Marsh, H. W. (1982). SEEQ: A reliable, valid, and useful instrument for collecting students’ evaluations of university teaching. British Journal of Educational Psychology, 52(1), 77-95. https://doi.org/10.1111/j.2044-8279.1982.tb02505.x

Marsh, H. W., & Bailey, M. (1993). Multidimensional students’ evaluations of teaching effectiveness: A profile analysis. The Journal of Higher Education, 64(1), 1-18. https://doi.org/10.1080/00221546.1993.11778406

Mishra, P., & Koehler, M. J. (2006). Technological pedagogical content knowledge: A framework for teacher knowledge. Teachers College Record, 108(6), 1017-1054. https://doi.org/10.1111/j.1467-9620.2006.00684.x

Moore, J. L., Dickson-Deane, C., & Galyen, K. (2011). e-Learning, online learning, and distance learning environments: Are they the same? The Internet and Higher Education, 14(2), 129-135. https://doi.org/10.1016/j.iheduc.2010.10.001

Moore, M. G., & Kearsley, G. (2012). Distance education: A systems view of online learning (3rd ed). Wadsworth Cengage Learning.

Nguyen Tan, D. (2017). Les TIC au service de la qualité des formations : le cas des programmes vietnamiens évalués par l’ASEAN University Network [thèse de doctorat en sciences de l’éducation]. Université de Strasbourg. http://www.theses.fr/2017STRAG004

Nunnally, J. C., & Bernstein, I. H. (1994). Psychometric theory (3e ed.). McGraw-Hill.

Oanh, L. T. M., & Thuý, N. T. N. (2020). Ðánh giá hiệu quả học tập trực tuyến của sinh viên trong bối cảnh dịch bệnh Covid 19 [Assessing the effectiveness of students’ online learning amid the COVID-19 epidemic]. Tạp chí Khoa học Ðại học Quốc gia Hà Nội: Nghiên cứu Giáo dục [VNU Journal of Science. Education Research], 37(1), 92-101.

Ossiannilsson, E., & Landgren, L. (2012). Quality in e-learning: A conceptual framework based on experiences from three international benchmarking projects. Journal of Computer Assisted Learning, 28(1), 42-51. https://doi.org/10.1111/j.1365-2729.2011.00439.x

Pho, D.-H., Nguyen, X.-A., Luong, D.-H., Nguyen, H.-T., Vu, T.-P.-T., & Nguyen, T.-T.-T. (2020). Data on Vietnamese students’ acceptance of using VCTs for distance learning during the COVID-19 pandemic. Data, 5(3), 83. https://doi.org/10.3390/data5030083

Quality Matters. (2018). Specific review standards from the QM higher educaton rubric (6e éd.). Quality Matters. https://www.qualitymatters.org/sites/default/files/PDFs/StandardsfromtheQMHigherEducationRubric.pdf

Ramsden, P. (1991). A performance indicator of teaching quality in higher education: The Course Experience Questionnaire. Studies in Higher Education, 16(2), 129-150. https://doi.org/10.1080/03075079112331382944

Richardson, J. C., Maeda, Y., Lv, J., & Caskurlu, S. (2017). Social presence in relation to students’ satisfaction and learning in the online environment: A meta-analysis. Computers in Human Behavior, 71, 402-417. https://doi.org/10.1016/j.chb.2017.02.001

Sankar, A., & Kiruthikaa, K. (2014). Community based recommendation in e-learning systems. Journal of e-Learning and Knowledge Society, 10(1), 51-61.

Schofield, A. (1998). Benchmarking: An overview of approaches and issues in implementation. In Benchmarking in higher education: An international review, 8, 12 -31. UNESCO. https://unesdoc.unesco.org/ark:/48223/pf0000112812

SEAMEO. (2010). Report. Status of ICT integration in education in Southeast Asian countries. Southeast Asian Ministers of Education Organization (SEAMEO) Secretariat.

Stracke, C. M. (2006). Process-oriented quality management. Dans U.-D. Ehlerset et J.M.Pawlowski (dir.), Handbook on quality and standardisation in e-learning (p. 79-96). Springer.

Stracke, C. M. (2009). Quality development and standards in e-learning: Benefits and guidelines for implementations. Proceedings of the ASEM Lifelong Learning Conference: e-Learning and Workplace Learning.

Tavakol, M., & Dennick, R. (2011). Making sense of Cronbach’s alpha. International Journal of Medical Education, 2, 53-55. https://doi.org/10.5116/ijme.4dfb.8dfd

Thanh, P. T. N., Thông, N. N., et Thảo, N. T. P. (2020). Cảm nhận của sinh viên chính quy khi trải nghiệm học trực tuyến hoàn toàn trong thời gian phòng chống dịch Covid-19 [Perception of fulltime students’ experience of full online learning during COVID-19 pandemic]. Tạp chí Khoa học Ðại học Mở TP. HCM – Kỷ yếu [Ho Chi Minh City Open University Journal of Science - Proceedings], 15(2), 18-28. https://doi.org/10.46223/HCMCOUJS.proc.vi.15.2.1828.2020

Thompson, A. D., & Mishra, P. (2007). Breaking news: TPCK becomes TPACK! Journal of Computing in Teacher Education, 24(2), 38-64. https://www.tandfonline.com/doi/pdf/10.1080/10402454.2007.10784583

Tu, C.-H., & McIsaac, M. (2002). The relationship of social presence and interaction in online classes. American Journal of Distance Education, 16(3), 131-150. https://doi.org/10.1207/S15389286AJDE1603_2

Venkatesh, V., Morris, M. G., Davis, G. B., & Davis, F. D. (2003). User acceptance of information technology: Toward a unified view. MIS Quarterly, 27(3), 425-478. https://doi.org/10.2307/30036540

Weiss, C. H. (1983). Toward the future of stakeholder approaches in evaluation. New Directions for Program Evaluation, 17, 83-96. https://doi.org/10.1002/ev.1328

Williams, K., Kear, K., & Rosewell, J. (2012). Quality assessment for e-learning: A benchmarking approach (2e éd.). European Association of Distance Teaching Universities (EADTU).

Wilson, K. L., Lizzio, A., & Ramsden, P. (1997). The development, validation and application of the Course Experience Questionnaire. Studies in Higher Education, 22(1), 33-53. https://doi.org/10.1080/03075079712331381121

World Bank. (2020 ). Improving the performance of higher education in Vietnam. Strategic priorities and policy options (p. 76). The World Bank.

Younès, N., & Romainville, M. (2012). Les transformations actuelles de l’EEE. Mesure et évaluation en éducation, 35(3), 175-199. https://doi.org/10.7202/1024674ar

Tang Ba Hoang, PhD, Directeur du Centre des technologies de l'information et de la formation en ligne, Université de Hanoi, Vietnam. Il a obtenu son doctorat en sciences de l’éducation à l’Université de Strasbourg. Ses recherches portent sur l’e-learning et l’intégration des TIC dans l’enseignement supérieur. Courriel : hoangtb@hanu.edu.vn ORCID : https://orcid.org/0000-0002-5944-527X

Nguyen Tan Dai, Chercheur associé, Laboratoire interuniversitaire des sciences de l’éducation et de la communication (LISEC – UR 2310), Université de Strasbourg, France. Il a réalisé sa thèse en Sciences de l’éducation au LISEC et l’a soutenue avec succès en avril 2017. Ses travaux de recherche portent principalement sur les techonologies éducatives et l’assurance qualité dans l’enseignement supérieur. Courriel : dai.nguyen-tan@alumni.unistra.fr ORCID : https://orcid.org/0000-0002-0058-9922

Nguyen Huu Binh, PhD, Enseignant-chercheur à l’Université de Langues Étrangères, Université de Danang, Vienam. Il a obtenu son doctorat en langue et littérature à l’Université de Liège, Belgique. Ses recherches portent sur la linguistique appliquée et l’application des technologies de l'information à l'enseignement. Courriel : nhbinh@ufl.udn.vn ORCID : https://orcid.org/0009-0002-9252-3134

Ngo Ba Hung, Enseignant-chercheur à l’Université de Can Tho, Vietnam. Il possède plus de 20 ans d’expérience dans l’enseignement supérieur dans le domaine des technologies de l’information et de la communication, avec une expertise particulière en réseaux informatiques, cloud computing, systèmes répartis et big data. Il développe également des solutions de transformation numérique dans les domaines de l’éducation et de l’administration électronique, et se spécialise dans la pratique et la formation à l’enseignement en ligne. Courriel : nbhung@ctu.edu.vn ORCID : https://orcid.org/0009-0003-5670-4680

Vo Viet Minh Nhat, Professeur associé à l’Université de Hué, Vietnam. Il a obtenu son doctorat en informatique cognitive à l’Université du Québec à Montréal, Canada, en 2007. Ses recherches portent sur les réseaux de commutation optique par paquets/boucles, les systèmes mobiles d'identification par radiofréquence (RFID) et les capteurs, l'informatique douce, les réseaux neuronaux, l'informatique évolutive et les technologies de l'éducation. Courriel : vvmnhat@hueuni.edu.vn ORCID : https://orcid.org/0000-0002-0686-5529

Nguyen Thi Anh Dao, Département de l’Assurance qualité, Université Nguyen Tat Thanh, Vietnam. Elle a obtenu un master en Évaluation et mesure de l’éducation à l’Université nationale du Vietnam à Hanoi. Ses recherches portent sur l'assurance qualité et le développement durable dans l'éducation. Courriel : ntadao@ntt.edu.vn ORCID : https://orcid.org/0009-0000-2868-7332

Dinh Thi Hai, Département de Gestion Scientifique, Université de Hanoi, Vietnam. Elle a obtenu son master à l’Université Rey Juan Carlos, en Espagne, en 2012. Ses recherches portent sur la méthodologie de l’enseignement de l’espagnol comme langue étrangère. Courriel : haidt@hanu.edu.vn ORCID : https://orcid.org/0009-0005-0826-4785

Vu Tien Dat, Centre des technologies de l'information et de la formation en ligne, Université de Hanoi, Vietnam. Il est titulaire d’un master en Formation des enseignants de mathématiques de l’Université nationale du Vietnam à Hanoi. Ses recherches portent sur la méthodologie de l'enseignement, l'apprentissage en ligne et les technologies éducatives. Courriel : datvt@hanu.edu.vn ORCID : https://orcid.org/0009-0001-7648-3729